文/VR陀螺万里

从ChatGPT开始引爆大语言模型,然后到后来国内掀起百模大战,现如今,AI之火愈演愈烈,目前市场已经步入关于AI大模型的应用落地阶段。在这个过程中,端侧AI的发展始终是难以忽视的一环。

所谓端侧AI,指的是不依赖于云服务器,能够直接在设备本地所运行的AI体验。目前GPT-4、Llama2等主流的大语言模型仍需要调用云端接口算力,因而其在应用过程中始终存在一定局限性,在算力、续航以及模型体积掣肘的当前,端侧AI应该如何发展落地?

可靠、强隐私,是端侧AI的核心优势

去年,高通曾在一份报告中透露了有关端侧AI的四大关键优势,其中包括:降低成本、可靠性、隐私安全以及个性化。

展开来看,关于成本问题,由于端侧AI完全基于本地运行,无需额外调用云端API,因而边际使用成本无限趋近于电费。早些时候,面壁智能CEO李大海曾做了一个测算:用一台搭配骁龙855芯片的手机在本地端跑大模型,按照运行5年计算,每秒7.5tokens,那么170万tokens的推理成本仅需人民币1元,成本仅为Mistral-Medium的百分之一。

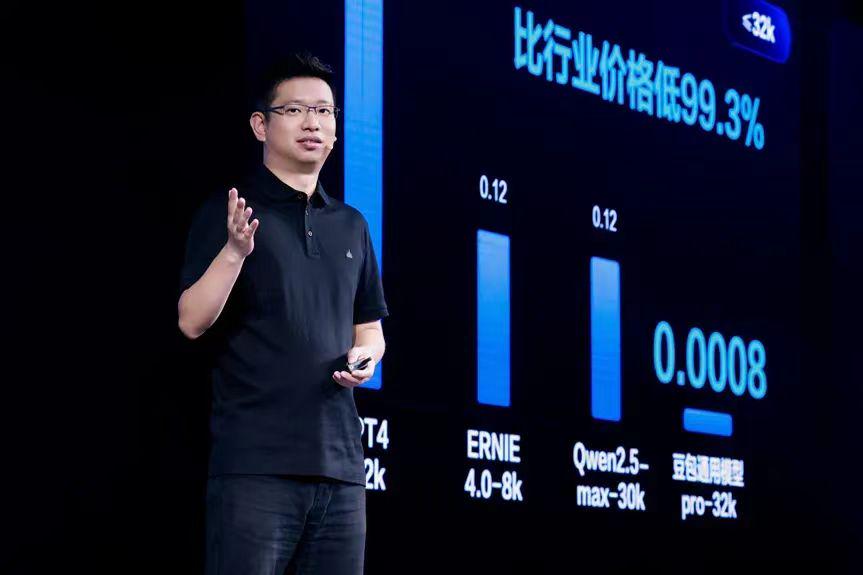

(Ps:话说回来,随着近期一众国内AI云服务厂商吹响价格战的号角,端侧AI的价格优势可能并不会那么快凸显出来。)

端侧AI的实践:AIPC、AI手机

今年3月,微软专门针对“AIPC”定了一个标准,其中包括三大方面:基于Windows系统、具备本地运行Copilot的能力以及配备性能最少为40TOPS的NPU(神经网络处理单元),其实这背后所强调的正是设备应当具备的端侧AI能力。

(值得一提的是,如果严格按照微软给出的定义,即便基于CPU+GPU组合的传统电脑性能足够强劲,由于它没有配备NPU单元,那么它也无法称之为AIPC,今年英伟达在一场新闻发布会中对此进行了嘲讽。)

近日的Build年度全球开发者大会上,微软进一步带来了“Copilot+PCs”的新概念,它可以视为“AIPC”的升级版:Windows笔记本电脑需要配置内置AI硬件并支持整个操作系统的AI功能。

对此,微软为Windows系统引入了全新的架构,在AI方面,采用了在Azure云运行大型语言模型+本地端运行小型语言模型(SLM)的组合,SLM旨在提供与大模型类似的能力,但是它们对于硬件需求大大降低,很多AI体验可以直接在本地运行。

发布会期间,微软CEOSatyaNadella展示了多项系统级端侧AI能力更新:如提供实时音视频字幕、草稿实时生成高质量画作以及前面所提到的回顾功能等。

图源:网络

首批获得Copilot+PCs认证的产品均配备了高通的XElite以及XPlus处理器,它们拥有45TOPS的AI算力,作为参考,XElite能以30token/s的速度本地运行Llama270B版本。

图源:高通

而在Mac阵营,虽然苹果在AI方面“相对”低调,不过实际上它也在积极着手于将端侧AI体验引入电脑等产品中。

5月的苹果发布会上,新款ipadPro甚至抢先Mac系列产品线配备了最新的M4芯片,该芯片NPU算力可达38TOPS,库克表示新款iPad性能甚至足以傲视当今的AIPC。本次iPad发布会并没有展示生成式AI相关内容,不过里面出现了基于FinalCutPro的一键去处视频背景以及LogicPro的自动生成贝斯音效的端侧AI功能。

图源:苹果

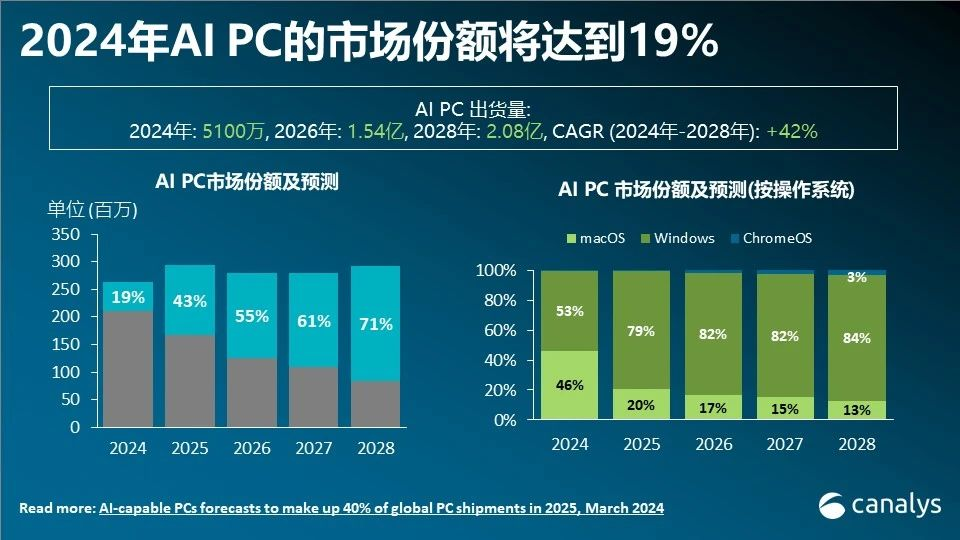

电脑性能强劲,并且天然具备生产力属性,所以端侧AI率先在电脑平台落地不足为奇。外界很多人将今年称之为AIPC元年,调研机构Canalys预测今年AIPC市场份额有望达到19%,出货量达到5100万。

图源:网络

除电脑以外,一众手机厂商也在探索AI在设备端的落地,今年以来,“AI手机”的概念也开始频频传出,所谓AI手机,OPPO所给出的定义是AI手机需要具备:创作能力、自学习能力、真实世界感知能力、算力高效利用能力。今年联发科发布了一份《生成式AI手机产业白皮书》,里面提到:生成式AI手机是利用大规模、预训练的生成式AI模型,实现多模态内容生成、情境感知,并具备不断增强的类人能力。

由此可见,目前市场关于“AI手机”是什么依然没有统一的共识,不过,它或许跟AIPC一样,要求手机具备一定AI算力,并能提供一定的端侧AI体验。

图源:Counterpoint

去年高通骁龙8Gen3发布会期间,高通曾展示了将LLM“塞入”手机的能力,高通表示搭载骁龙8Gen3的设备可在本地运行从3B到13B的大模型;而联发科在近期开发者大会期间也表示天玑9300+能够在端侧运行Llama27B版本,速度可达到22token/s。

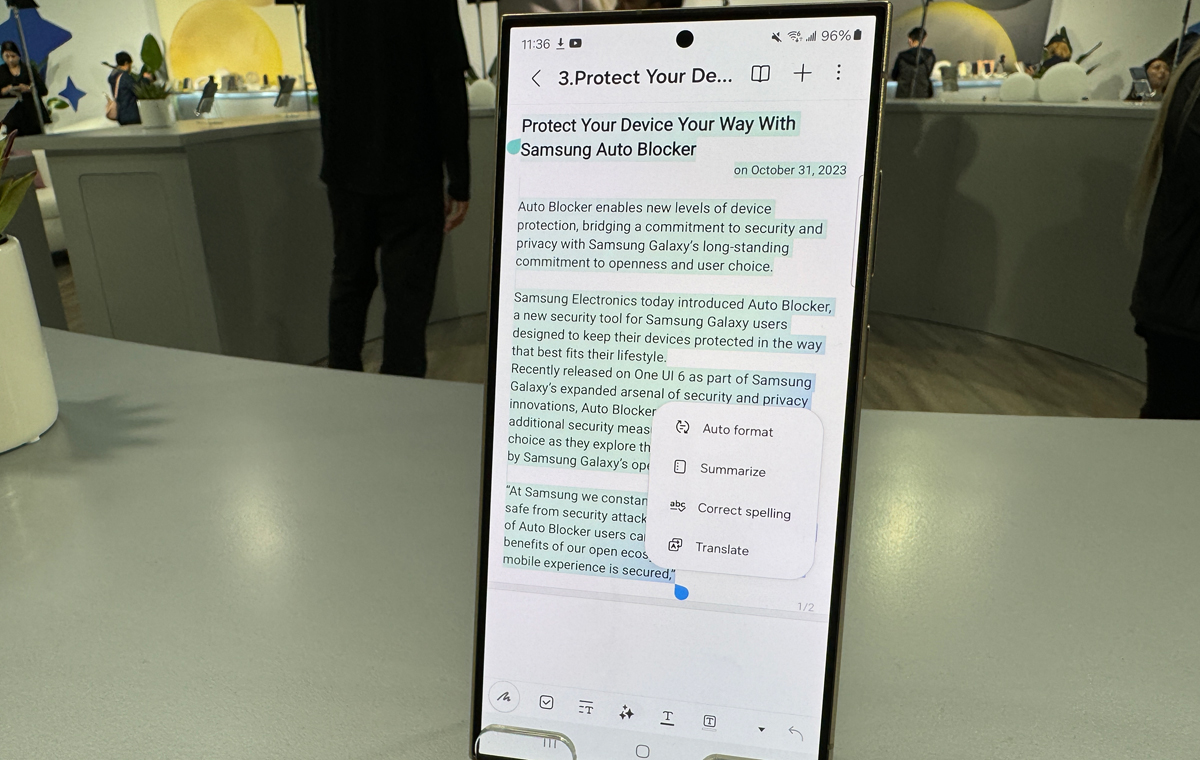

考虑到智能手机属于小算力、低功耗设备,将大模型直接部署在手机端其实并不现实。未来,AI手机也将会采用“端+云”混合AI的策略,在云端部署大模型,在端侧部署小模型。以今年三星所发布的S24系列机型为例,设备端集成了实时通话转文本、口译员、视频转慢动作等功能,此外,它还可以结合云端大模型实现画圈搜索、文章总结等AI功能。

三星的NoteAssist功能,图源:网络

对于苹果而言,苹果的生成式AI技术更侧重于“为最终用户带来实际利益,同时尝试使用端侧AI来保护用户隐私”。有爆料称今年iOS18将会出现以下端侧AI功能:自动汇总通知、为新闻和语音备忘录生成摘要、日历添加建议、照片AI编辑等。

端侧AI如何与VR/AR相结合

继电脑手机以后,下一步,则是将AI引入VR/AR等可穿戴式设备当中,对于AR设备而言,里面最具想象力的莫过于AI语音助手,不过由于可穿戴式设备对于功耗要求极为苛刻,对此想要实现端侧运行会更为困难。

以Ray-BanMeta上面所搭载的AR1芯片为例,该芯片的功耗仅有1瓦级,手机芯片功耗为10瓦级,而电脑主机能达到上百瓦,这背后其实也能简单换算不同设备的性能差距。

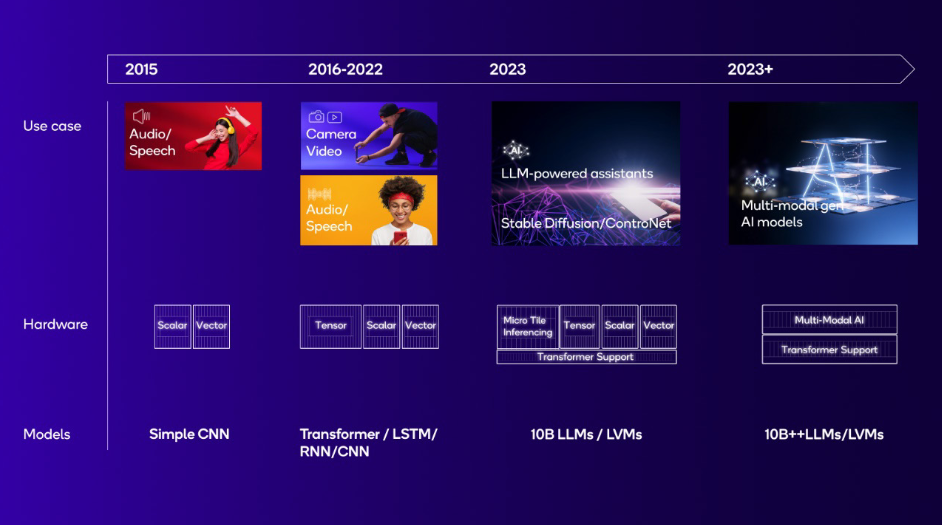

今年年初,高通发布了一份关于NPU的白皮书,里面描述了高通NPU的发展历程,早些时候SOC专门引入NPU模块旨在用于解决音频和语音相关问题,2016年以后NPU开始更加专注于处理计算摄影,而现在,随着LLM和LVM的发展,它对于NPU提了更高的要求。

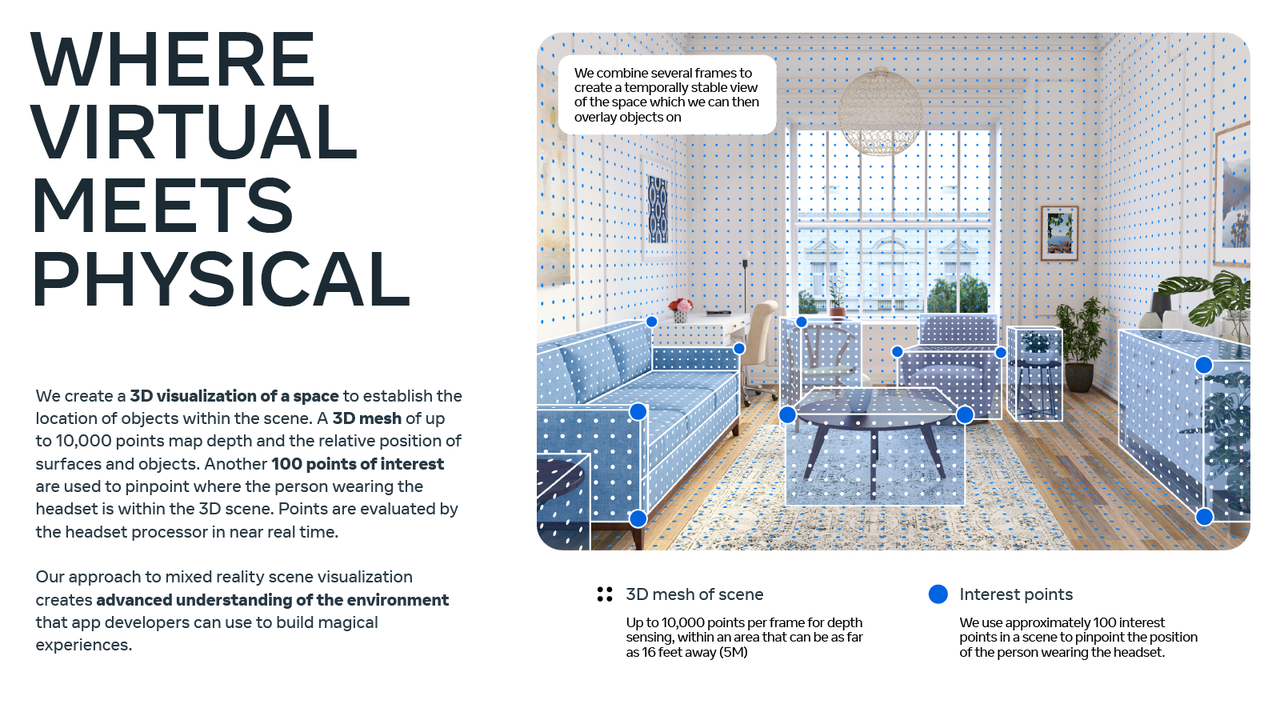

回到VR/AR设备来看,既然将LLM、LVM引入设备终端不切实际,我们可以先从音频降噪、视觉增强、空间感知等简单场景切入以解决部分问题,实际上,这也是Meta、苹果等厂商正在努力的方向。

图源:高通

今年1月,Mtea在其博客文章中讲解了关于AI应用于VR/AR的系列用例,其中包括:

- 基于AI取代传统的计算机视觉算法,可进一步提升环境识别能力以及记忆能力,在Questv64版本更新中,设备甚至具备了识别家具的能力;

- 基于AI模型以及机器学习算法,让手柄能将红外追踪环隐藏起来;

- 基于AI的手势交互、身体追踪;

- AI实现Ray-BanMeta的麦克风阵列降噪,从而提升通话视频体验。

图源:Meta

对于VisionPro而言,它也在积极落地相应的AI体验,如即将引入实时字幕(LiveCaptions)辅助功能,启用后,用户将能在屏幕上实时查看对话的文字信息,全局可用。(目前关于该功能的介绍仍不算多,猜测应该支持离线运行)。

图源:网络

由于VisionPro配备了电脑级芯片,因而未来引入完全基于端侧的AI语音助手其实也并非不可能。今年1月,苹果发布了一篇名为《LLMinaflash:EfficientLargeLanguageModelInferencewithLimitedMemory》,里面阐述了如何解决将LLM引入手机终端时遇到的手机内存不足的问题。有数据指出,70亿参数的模型需要14GB以上的内存才能加载半精度浮点格式的参数,这对于VisionPro而言压力其实不算很大。(VisionProNPU算力约15.8TOPS,配备16GBRAM)

此外,近期苹果在AI方面动作频频,以下这些AI体验/能力除了应用于未来的手机电脑终端外,它们同样可以应用于VR/AR设备当中:

- 今年2月苹果发布MGIE模型,用户基于文本即可实现图像的简单编辑,如增加图片对比度、为照片引入新元素等;

- 今年4月苹果发布开源LLMOpenELM,最低参数量仅有2.7亿,它与微软Phi-3类似,非常适合运行于手机等小型化设备当中;

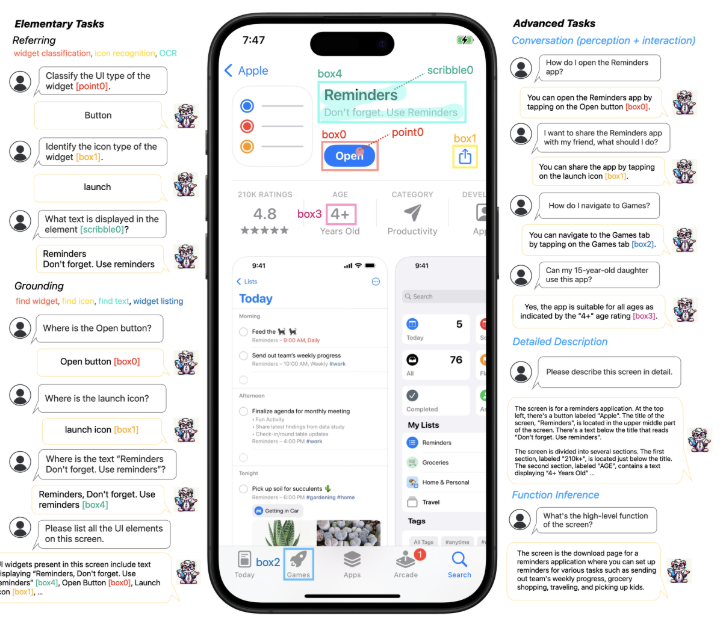

- 今年4月苹果发布手机端多模态大模型Ferret-UI的相关论文,Ferret-UI能够非常高效地识别屏幕的UI元素,并具备较强的推理能力,未来用户有望实现通过Siri一键打车等操作。

图源:苹果

总而言之,端侧AI的发展,其实是AI广泛应用落地的必由之路,这背后,需要考验AI厂商的算法能力、芯片厂商的硬件设计能力以及终端厂商对于市场以及消费需求的洞察。

早些时候,OpenAI发布了其最新的多模态大模型GP-4o,模型具有极快的语音响应,并且具备文本、语音以及视觉多模态理解能力,如果未来我们真的能够将这一大模型安放在本地,那么科幻电影《Her》时刻,也将真正到来。

参考资料:

https://www.qualcomm.com/content/dam/qcomm-martech/dm-assets/documents/Unlocking-on-device-generative-AI-with-an-NPU-and-heterogeneous-computing.pdf

https://www.meta.com/zh-cn/blog/quest/ai-powered-technologies-quest-3-pro-ray-ban-meta-smart-glasses/

https://www.macrumors.com/roundup/ios-18/

https://www.qualcomm.com/news/onq/2023/08/5-benefits-of-on-device-generative-ai