文/VR陀螺冉启行

“因为移动设备(VisionPro)的算力是有限的,也就是说如果用移动设备自己运算的话,始终无法得到一个非常理想的高保真的最终渲染结果,无论是精度或者延迟,或者是否符合物理定律,这是非常巨大的挑战。”

“也就是说必须结合云端的算力和边缘的算力,以及用流媒体的方式去呈现,这可能是以现阶段比较现实,也比较折中的一个理想的解决方案。”NVIDIA中国区高级技术市场经理施澄秋告诉VR陀螺。

近日,NVIDIA举办Post-GTC设计与仿真媒体交流会,作为长期关注前沿科技发展的行业媒体,VR陀螺受邀参加本次活动。

NVIDIA全球副总裁、亚太区专业可视化计算总经理沈威、NVIDIA中国区高级技术市场经理施澄秋、NVIDIA中国Omniverse业务负责人何展出席了本次活动。分别就GTC2024Omniverse相关发布亮点回顾、Omniverse行业应用案例进行了主题分享。

作为NVIDIA在中国区的特色活动之一,NVIDIA还与VR陀螺以及其他媒体就NVIDIA在Omniverse、数字孪生技术上布局,以及市场落地等方面的问题进行了深入探讨。

一、从3D原材料到精加工,VisionPro+OmniverseCloud

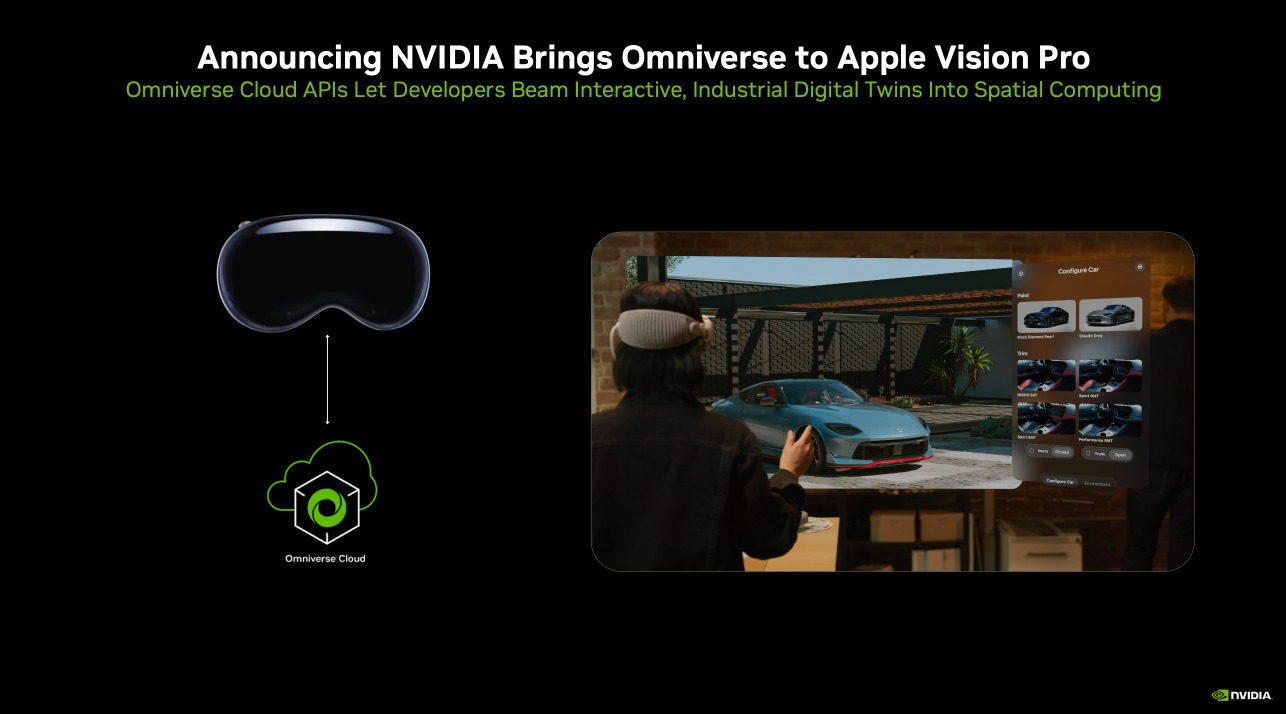

今年GTC上,NVIDIA宣布将以API形式提供NVIDIAOmniverseCloud,从而将全球领先的工业数字孪生应用和工作流创建平台的覆盖范围扩展到整个软件制造商生态系统。

借助五个全新OmniverseCloud应用编程接口(API),开发者能够轻松地将Omniverse的核心技术直接集成到现有的数字孪生设计与自动化软件应用中,或是集成到用于测试和验证机器人或自动驾驶汽车等自主机器的仿真工作流中。

NVIDIA展示了一个完全交互式的汽车模型,该模型被高保真传输到AppleVisionProVR头显中。其中,应用到了OmniverseCloudAPI接口技术,实现了高精度的3D模型渲染。

我们知道AppleVisionPro拥有M2+R1的强大芯片组合,那么为什么苹果不直接在端侧加载3D内容,转而借用NVIDIAOmniverseCloudAPI呢?

对此,施澄秋告诉VR陀螺:“因为移动设备的算力是有限的,也就是说如果用移动设备自己运算的话,始终是无法得到一个非常理想的高保真的最终渲染结果的,无论是精度或者延迟,或者是否符合物理定律,这是非常巨大的挑战。也就是说必须结合云端的算力和边缘的算力,以及用流媒体的方式去呈现,这可能是以现阶段比较现实也比较折中的一个理想的解决方案。”

具体来看,施澄秋强调NVIDIA在该传输流程中扮演一个重要的角色,他表示NVIDIA有GDN技术,Omniverse里的GPU是已经准备好的,这些GPU是顶尖的RTXGPU,RTXGPU里共有三个最核心的技术点:

1.传统着色的部分,可以用来做像素的渲染,能够确保画面是美轮美奂的;

2.光线追踪加速。用包裹体便利的方式去做实时光线追踪,在这个部分,我们能够用相对而言以前路径追踪或各式各样实时去支持,比如多次迭代的方式,用实时光线追踪的方式,显然延迟更低,同时可能帧率会很高,对于用户的互动性也更强,这是RTXGPU里最核心的部分;

3.Tensor,RTXGPU里都有针对张量运算的Tensor运算的核心,所以它又可以进行人工智能的加速,比如像大模型的部分,比如像GenAI的部分,比如像NeuralGraphics,像现在很火的NeRF等,我们都可以用人工智能的方式去运算。所以RTX是非常高阶的、有分门别类的、针对不同运算需求来提出专门的运算模型,同时它不仅仅能够分门别类的去运算,整体而言又是一个通用处理器,又可以用GPU的方式去运算。

“所以,在云端要Omniverse的API来打造和连接各式各样的应用程序,再用基于USD或OpenUSD的方式去打通数字资产之间的连接和现在调用,最后又通过RTXGPU强大的算力和高保真符合物理定律的实时光线追踪的方式,去完成画面的渲染。”

施澄秋用了一个通俗的形象比喻说道:“就是说从原材料到粗加工,到精加工,最后给你端上一盘可口的饭菜,以此让AppleVisionPro用户看到在这个空间计算里面呈现在他眼前的是实实在在3D的空间场景,这是我们在增强型的空间计算和高仿真体验方面带来的合作,也可以面对当前用户需求,看到有这样的需求,我们提供这样的合作,能够应对这样的机会,能够解决一些以前解决不了的挑战。”

二、NVIDIAOmniverseCloud的3D渲染,如何匹配VisionPro的单眼4K?

AppleVisionPro配备了单眼4K分辨率的Micro-OLED微显示器,通过Pancake折叠光学方案,形成了重要的近眼显示光学系统。

相比于传统的XR头显,VisionPro提供了更高的像素密度,人眼可见像素多了,这也对3D模型的渲染提出了更高的要求。

施澄秋表示,NVIDIA正在使用很多技术,去匹配相关渲染精度,以适应用户需求。他说道:“人眼看到的分辨率受制于你的显示设备,你的实实在在物理存在的分辨率,这是第一道门槛。第二道门槛,物理存在的分辨率,后端用什么样的分辨率去渲染?

“RTXGPU有很多复杂的特性,卷曲的方式,就是可以略过你当前没看到的画面,以较低精度的方式去渲染没看到的画面,以高精度去渲染你当前看到的画面(注视点渲染技术)。也就是说我有相当多的视野以外的低精度预渲染方式在后台运行,这个很重要。当然,它可能建立在一个运动预测和模型感知基础上,这是一种实现的方式。”

除了3D模型在渲染方式上的具象化,施澄秋还强调生成式AI的重要性。他表示:“另外一个实现的方式就是AI,GenAI很重要。我们用GenAI可以动态实时的支持破损画面的修复,支持缺失像素的填补。听起来很玄幻,因为有很多画面是用低渲染度方式渲染的,也就是说4K分辨率可能只用1080P的分辨率去渲染,也就是说有3/4的像素都没有被渲染,只渲染了1/4的像素,这时候用GenAI方式自动渲染,类似于神笔马良的方式去渲染另外的3/4没有被渲染出来的画面,可以快速用一个1080P低渲染精度,用GenAI方式生成一个4K渲染。”

“游戏开发商或基于Omniverse、基于虚幻引擎或Unity很多客户做3D场景或数字孪生构建时,也可以利用这个技术,我们叫做DLSS技术。这个不仅对于游戏开发商有用,对于数字孪生、数字资产的管理,包括VR/XR的方式也一样可以使用,这是一个渲染精度的方式。因为单眼4K分辨率太高了,想要做光线追踪,要做物理模拟,其实是很困难的,所以必须要把算力推动到最集中的视野中间去,其他有一部分可以用AI解释。这其实是我们几个实现方式之一,像DLSS等,比如NeuralGraphic的方式、用NeRF的方式去实现也是可以的。”

相关阅读:

“NVIDIA的Omniverse合作案列中常常使用全保真或高保真的渲染概念。施澄秋解释道:“这很容易理解,看到的部分眼见为真,首先看到的是真的,但是看到的可能是一个静止画面,也有可能是一个动态画面,就像第一个视频演示里我给大家介绍Omniverse能做什么,它能做基于空气动力的模拟仿真,可以基于粒子的仿真,比如仿真烟雾、仿真粒子系统火焰、光影等,这些都是实时模拟系统,这时候需要利用NVIDIAGPU的Physics的模型技术去实现。”

“同时,要做到低延时的方式,也就是说用你的AR/VR设备查看内容时,如果头转动的时间跟画面同步不匹配的话,就像人坐车一样,大脑、小脑,眼睛看到的和运动感知的交感神经系统不匹配的话,就会产生头晕。所以如果VR算得不够快、延迟不够低的话,可能会晕,甚至严重时会恶心、想吐。所以,全保真也好、高保真也好,不仅看到的画面要细腻、要逼真,分辨率要高,同时物理模拟,比如像云、光影、火焰、粒子、空气、动力,整个要符合自然界真实的规律,同时还要能够在我们的头戴设备上实现低延迟屏幕画面的呈现——这个我们叫做全保真。”

“通俗地说就是数字孪生,看元宇宙世界时,跟真实的世界以现在的阶段不能说做到完全一模一样,至少要现有的能力更好的贴近和接近现实,这个称之为全保真。”

三、聚焦Graphic,GDN可做光线追踪、AI模拟

在AppleVisionPro与OmniverseCloud的传输流程中,不难发现一个名为“GDN”的网络技术。

我们知道传统云计算厂商可以提供的全球化CDN服务,同样可以实现云端快速加载GLTF或GLB的3D模型文件,那么NVIDIA的GDN服务相比于前者又有哪些差异化特征呢?

“CDN是ContentDeliveryNetwork,GDN实际上也DeliveryContent,但是它主要是聚焦在Graphic方面,所以叫GDN。”施澄秋告诉VR陀螺。

“CDN同样可以快速加载,比如GLB等3D模型文件也同样可以用分布式的方式就近去提供内容,能够实现非常低延迟的方式,但是最核心的优势在于我们的GDN可以做物理模拟,可以做光线追踪,可以做整个人工智能的模拟,可以做相应的RTXGPU能够完成的非常好的、高阶的功能。在这里可以看到CDN不能做的事情,GDN能做,而CDN能做的事情,GDN基本都能做,我们GPU里有Decode、Encode,各式各样高级的编解码方式,我们完全可以实现。”

“所以可以把GDN当做是CDN一个更优化、更高阶、更进阶的全面的解决方案。计算成本不言而喻,因为渲染时GPU能耗比非常强大,所以把许多渲染好的高精的画面用Encode+Decode的方式输送到用户终端设备上去。对于接收端的设备而言,功耗方面的影响非常小,所以整个GDN的方式能够以现有CDN方式提供更好、更优化的Graphic内容的解决方案,能够完成这样的需求。”

四、XR上大算力云,B端先行一步

依托NVIDIA强大的算力,在数字孪生产业布局方面,NVIDIA走在了云端技术供应链的前面。

在生态方面,NVIDIA去年与皮克斯、Adobe、Apple、Autodesk这些行业领先的企业一起成立了OpenUSD联盟,来推动OpenUSD的标准化和国际化。

在落地应用层面,NVIDIA正在和西门子、微软、罗克韦尔自动化等行业领先企业展开合作,帮助他们采用Omniverse技术,帮助客户设计、模拟、构建、运行符合物理规律的数字孪生。

XR上云是未来的一个趋重要势,不过在C端的应用上仍有一定时间周期。正如,NVIDIA中国区高级技术市场经理施澄秋所言,XR等移动设备的算力有限,结合云端、边缘计算来渲染更精美的3D内容是一个理想的解决方案。然而,只有当B端的应用成功落地,比较顺畅的时候,才会推广到体量更大的C端去使用。

他举例谈到:“今天互联网应用很成熟,大家使用手机非常成熟,我们手机看爱奇艺、抖音、Bilibili、长视频、短视频,是从3G/4G普及时开始的,这是一个典型的C端应用,今天每个人都用手机看视频,可是便携式移动设备看视频在90年代时候就有了,从拨号上网时就已经有专门用来做商用的影像视频会议系统,这已经是串流的一种应用方式了,用了二十年时间才从B端走到C端上,因为B端用户有购买力,它是一个专业解决方案,需要使用这个来作为它的生产力工具。”

“所以,可以看到云端的3D内容,在空间计算、AR/XR的应用上,一定是专业级用户对于最严苛的应用环境和应用场景情况下,我们先去完成他的需求。因为第一,他对于成本的敏感性不高;第二,他对于基础建设和使用的终端设备上投入预算的限制也没有C端用户那么高。

“总而言之,在算力和整个基础设施比较受限的现阶段场景下,我们可能首先去覆盖B端的用户,当整个使用成本、拥有成本、运营成本都降低了之后,AI也好或云端的算力得到大幅提升,我们的供给侧短缺不像现在这么受限的情况下,那个时候C端可能会真正的蓬勃发展起来,比如像游戏、娱乐行业,就可以通过VR/AR/XR的方式去实现。”