编译/VR陀螺

近日,美国商标专利局公布了苹果公司一项专利,该专利涉及电子设备,尤其涉及根据眼动追踪和头部追踪信息确定用户注视行为状态的系统、方法和设备。

苹果公司在其专利背景中指出,在电子设备上查看内容时,确定用户的意图可以促进更有意义的体验。例如,内容的一部分(如可选择的图标或按钮)可根据用户的选择意图自动进行选择,而无需用户执行手势、鼠标点击或其他基于输入设备的操作来启动选择。

然而,用户可能会做出不同类型的眼球运动,眼球运动的频率和特征可能取决于许多因素,包括任务、精神状态和身体姿势。因此,针对用户观看内容和与内容互动的意图,改进评估目标眼动事件的技术可以提高用户对内容的欣赏、理解和学习能力。内容创建者和系统能够以更高精度确定用户与部分内容互动的意图,从而提供更好、更量身定制的用户体验。

本文公开的各种实施方案包括提供实时注视分类算法的设备、系统和方法,该算法可根据眼动追踪数据,例如通过基于视频的眼动追踪仪、基于视网膜/眼底成像的眼动追踪、基于眼球电图的眼动追踪、基于磁性巩膜搜索的眼动追踪等获得的注视方向、凝视角度、瞳孔直径、瞳孔位置等,以及头部表示/追踪数据(例如,使用图像数据、深度数据、加速计数据、磁力计数据、陀螺仪数据等获得的头部姿势、旋转速度等)对眼动和注视行为类型进行分类。

将注视行为分类为离散的“事件”可用于改进基于注视的用户界面交互、用户意图预测、原始眼动追踪数据的选择性过滤,从而避免因过滤操作而增加延迟。在一些实施方案中,可以利用场景理解信息来确定当前环境中的物体表示数据(例如,位置、深度、与用户的距离、速度、场景中物体的运动方向)。

在某些实施方案中,本文所述技术可以对注视行为状态进行实时分类。例如,可以获取当前时间的眼球数据和头部姿势数据以及一些历史数据(例如,最近10次采样),以便以更低的延迟对当前时间的注视事件进行预测。

一些实施方案侧重于提高确定注视行为状态的准确性,以根据眼动追踪和头部姿势数据实时识别注视移动事件、注视保持事件和丢失事件,并确定眼动类型的样本事件级别。

眼球运动有多种不同类型,根据其功能或生理起源,可以对它们进行不同的分类。眼球注视行为事件或眼球运动包括:扫视移动(短暂、快速、急促和弹道式眼球运动,用于搜索/分析场景,并将视网膜的高敏锐度部分带到感兴趣的物体上)、平滑追逐(在物体移动时追踪物体,使视网膜的高敏锐度部分保持在感兴趣的物体上)、前庭-眼球反射(又称VOR,这是眼睛的代偿运动,目的是在头部运动/旋转的情况下仍能将视线固定在物体上)、固定注视(视线和头部相对固定,仅有偏移)、眨眼(一只或两只眼睛全部或部分闭合)、数据丢失(由于各种原因导致眼球追踪或头部追踪失败)等。

还可以进行更高层次的分类,将注视行为分为快速行为状态、稳定行为状态和丢失行为状态。快速行为状态可能指的是扫视移动。稳定行为状态可指用户试图将视线稳定在物体上的动作(如平滑追逐、VOR或固定事件)。丢失行为状态可指眨眼和/或其他数据损失,由于眼部/头部追踪的其他问题(如丢帧、分割问题、超出特定眼部追踪技术的追踪范围等),这些数据损失可被确定为丢失行为状态。

本专利要解决的一个普遍问题是创建一种分类算法,该算法可以实时解释设备上的眼部/头部追踪数据,且与用户的身体姿势或任务无关。

在一些实施方案中,可以采用机器学习算法或其他类型的分类算法,将眼球数据和头部追踪数据分类为行为和/或功能相关的事件。在某些实施方案中,算法和/或机器学习模型可以根据用户的特定操作进行配置/改进。

目标事件可以是固定、平滑追逐、扫视移动、VOR、眨眼、数据丢失等低级事件,也可以是稳定注视状态、快速注视状态和丢失状态等高级事件。机器学习分类器可使用用户在各种身体/头部姿势(如坐、站、躺、走等)下执行各种任务时的眼部和头部追踪数据进行训练。根据不同的身体姿势和任务要求,注视行为和统计数据可能会发生巨大变化。

此外,还可以使用场景环境来确定注视行为状态,以识别注视转移事件、注视保持事件和/或丢失事件。根据用户在交互事件(如选择图标)中的眼球运动和注视行为,用户所呈现内容和环境的这些属性可以更好地确定用户的意图。

在用户执行任务时,使用带有眼动追踪技术(和其他生理传感器)的设备可以获得生理数据。在某些实施方案中,可以使用其他传感器获取生理数据,例如脑电图(EEG)传感器或皮电活动(EDA)传感器。根据用户的眼球运动和注视行为,观察对体验的生理数据的重复测量,可以深入了解用户的意图。

在一些实施方案中,确定是否启动交互事件(例如,预测用户是否打算与显示内容的一部分进行交互)可以基于用户的特征(例如,生理数据)和用户的环境(例如,真实世界物理环境、虚拟环境或两者的组合)。

设备(如手持设备、笔记本电脑、台式机或头戴设备)提供真实物理环境或XR环境的体验(如视觉和/或听觉体验)。该设备通过一个或多个传感器获取与用户相关的生理数据(例如,脑电图振幅、瞳孔调制、眼球凝视扫视移动、由IMU测量的头部运动等)。根据获得的生理数据,本文所述技术可确定体验过程中的交互事件。基于生理数据和相关的生理反应(例如,用户专注于内容的特定区域),该技术可根据交互事件向用户提供响应,并调整与体验相对应的内容。

图源:ApplePatent20230418372

图源:ApplePatent20230418372

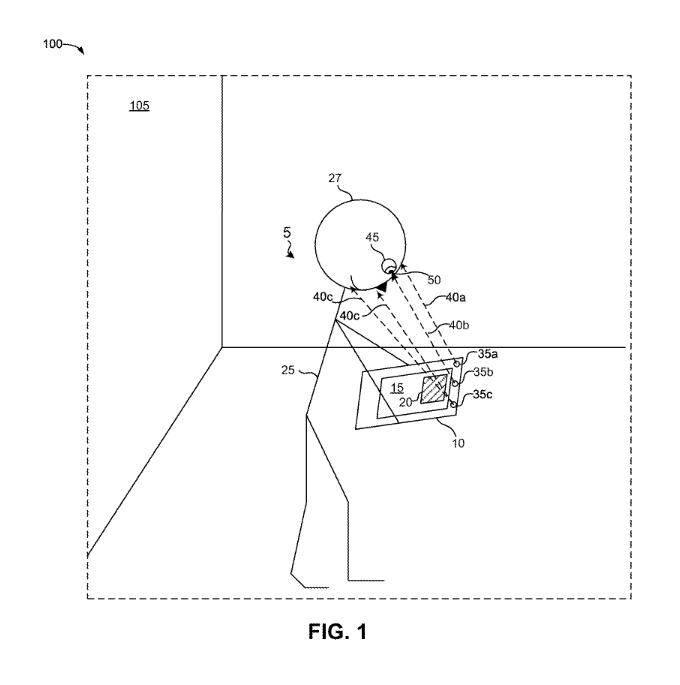

苹果专利图1展示了真实世界环境#105(例如房间)的示例环境#100,其中包括带有显示屏#15的设备#10。在某些实施方案中,设备#10向用户#25显示内容#20。例如,内容#20可以是按钮、用户界面图标、文本框、图形、用户或其他用户的头像等。在某些实施方案中,内容#20可以占据显示屏#15的整个显示区域。

图源:ApplePatent20230418372

图源:ApplePatent20230418372

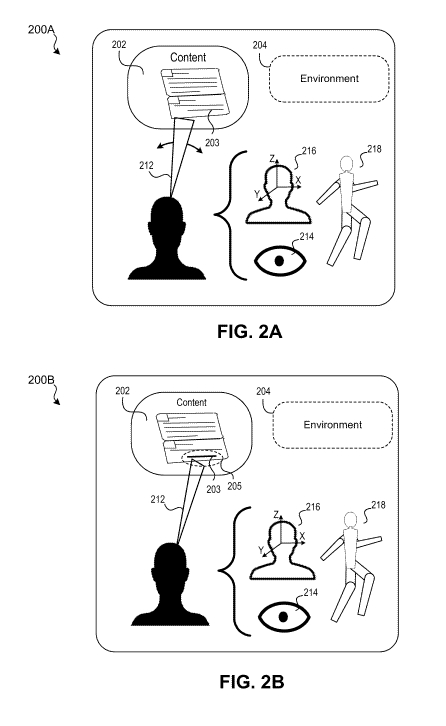

图2A和2B展示了根据生理数据检测用户观看内容时的眼球运动和注视行为。图2A展示了用户(例如图1中的用户#25)在内容呈现过程中在环境#204中被呈现的内容#202吸引,对内容做出了生理反应(例如,通过眼球注视特征数据#212检测到的用户看向内容的部分)。

想要了解更多专利细节,请查阅苹果专利申请20230418372。

来源: