编译/VR陀螺

近日,美国专利商标局发布了苹果2020年针对其眼动追踪系统的第四项专利申请。该专利涉及其未来的头戴式显示器(HMD)设备的高级眼动追踪/注视点技术的另一个方面。这项专利向我们介绍了眼动追踪系统如何能够使用摄像机数据获取用户的生物特征,然后自动调整图像的亮度,并将图像生成到HMD显示屏上等等。

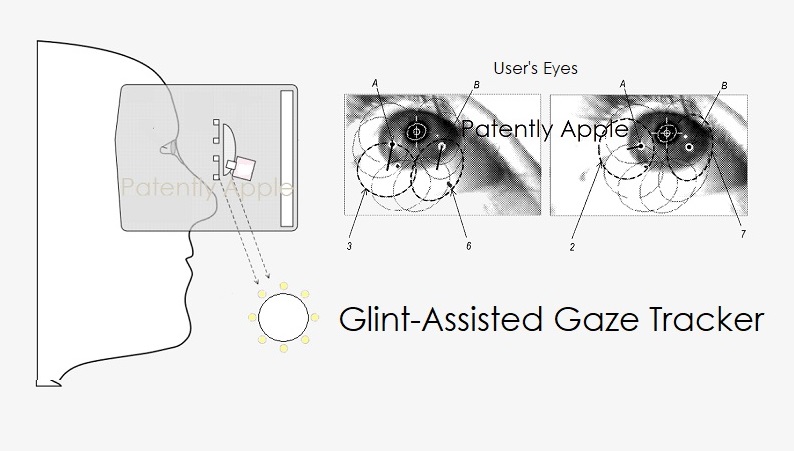

苹果的发明涵盖了一种包括眼动追踪系统的头戴式设备,该眼动追踪系统能确定头戴式设备用户的视线方向。眼动追踪系统通常包括将用户的眼睛图像传输到执行眼动追踪的处理器的摄像机。以足够的帧速率传输图像以实现眼动追踪,需要具有相当带宽的通信链路。

各种实现包括用于使用强度调制的光源确定眼动追踪特性的设备,系统和方法。该方法包括从多个光源向用户的眼睛发射具有调制强度的光,以多个闪烁的形式接收由用户的眼睛反射的发射光的强度数据指示。该方法还包括基于光强度数据确定用户的眼动追踪的特性。

苹果公司为强度调制光源的眼动追踪系统使用了机器学习。该系统可以执行一些非常独特的功能。例如,在一种情况下,一个或多个光源可根据用户生物特征调制发射光的强度。

例如,如果用户比正常人眨眼更多,心跳加快或被登记为儿童,则一个或多个光源会降低发射光的强度以减轻眼睛的压力。

作为另一示例,一个或多个光源可以基于用户的眼睛颜色来调节发射光的强度,因为与棕色眼睛相比,蓝眼睛的光谱反射率可能不同。

在各种实施方式中,眼动追踪或者特别是确定的注视方向,被用于实现用户交互,诸如允许用户注视HMD显示器上的弹出菜单,然后通过简单地注视屏幕来选择该菜单上的一个特定选项。

苹果的专利图1是示例操作环境#100的框图,其中,控制器(#110)被配置为用户管理和协调增强现实/虚拟现实(AR/VR)体验。

苹果的专利图4示出了头戴式设备(#400)的框图。外壳(#401)还容纳了眼动追踪系统,该眼动追踪系统包括一个或多个光源#422,相机424和控制器480。一个或多个光源422将光发射到用户10的眼睛上,并反射为光。

相机424可以检测到光模式(例如,闪烁的圆圈)。基于该光模式,控制器480可以确定用户10的眼动追踪特性。例如,控制器480可以确定视线方向和/或用户10的眨眼状态(睁眼或闭眼)。作为另一个示例,控制器480可以确定瞳孔中心,瞳孔大小或视点。因此,在各种实施方式中,光由一个或多个光源422发射,从用户10的眼睛反射,并由相机424检测。在各种实施方式中,来自用户眼睛10的光是在到达相机424之前从热镜反射或穿过目镜。

在专利图5A中,我们看到用户的眼睛具有第一凝视方向;图5B示出了具有第二凝视方向的用户眼睛。

在各种实施方式中,一个或多个光源朝着用户的眼睛发射光,该光以形成图案的多个闪光的形式反射。可以确定反射的图案(以及可能的其他特征,例如瞳孔大小,瞳孔形状和瞳孔中心),用户的眼动追踪特性。眼睛包括被虹膜包围的瞳孔,两者均被角膜覆盖。眼睛同时还包括巩膜(也称为眼白)。

苹果的专利图9A示出了包括摄像机(#910)的眼动追踪系统(#900)的功能框图。眼动追踪系统基于从摄像机接收到的事件消息来输出用户的凝视方向。

几何分析器#970从闪烁检测器(#940)接收与检测到的闪烁有关的数据,并且从瞳孔检测器(#960)接收与用户眼睛的瞳孔有关的数据。基于该接收到的信息,几何分析器确定用户的眼动追踪特性,例如用户的凝视方向和/或眨眼状态。

苹果的专利图9B示出了包括机器学习回归器#980的眼动追踪系统(#902)的功能框图。这里,闪烁检测器(#940),瞳孔检测器(#960)和几何分析器(#970)使用机器学习回归器,该回归器根据目标特征和脱离目标特征确定眼睛的跟踪特征。

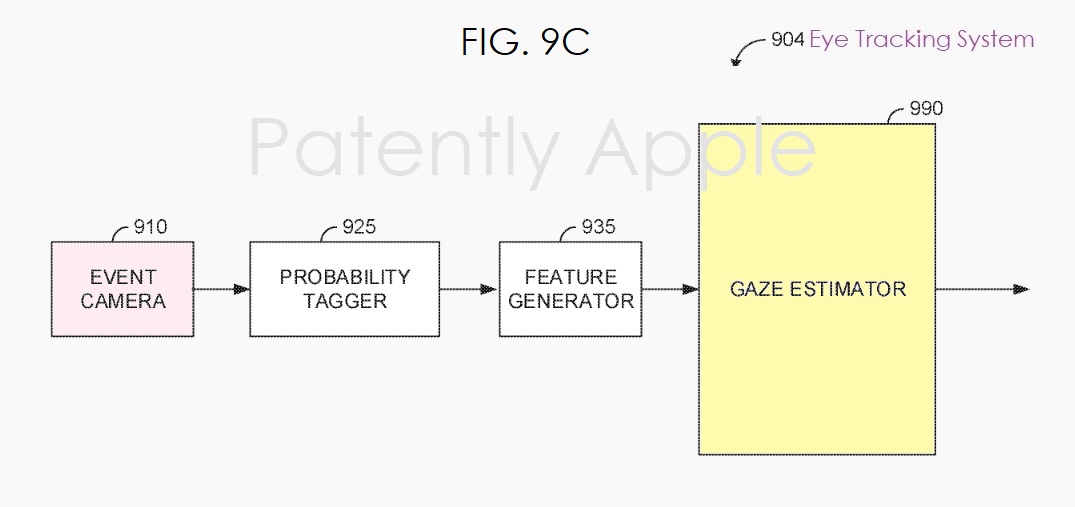

最后在专利图9C中,我们可以看到包括凝视估计器(#990)的眼动追踪系统(#904)的功能框图。此处的眼动追踪系统包括摄像头(#910)。事件消息被传送到概率标记器(#925)。

带有概率标记的事件消息被传送到特征生成器(#935),该特征生成器生成一个或多个特征,反馈到注视估计器(#990)中,该估计器基于一个特征来确定眼动追踪特性(例如,凝视方向)或更多功能。

美国专利局发布的这项苹果专利申请20200278539显示于2020年第一季度提交,尽管该专利表明某些工作最早可以追溯到2017年,但这些工作被一同并入了最新申请中。考虑到这是一项专利申请,目前尚不知道这种产品上市的时机。

该专利发明人包括:

DanielKurz:高级工程经理(计算机视觉,机器学习),通过苹果收购Metaio加入公司。这项专利的一些早期工作可能来自Metaio的收购,并由苹果团队成员进行了修订。

LiJia:居住在中国北京的计算机视觉和机器学习工程经理。其领导一个团队,为移动相机应用开发CVML算法。他还与清华大学组织了有关计算机视觉和机器学习研究项目的合作。

RaffiBedikian:计算机视觉工程师。他在LeapMotion工作了5年。

BrankoPetljanski:孵化(相机)工程经理

来源: