查看

实现快速高效的低延迟立体视频串流

(

针对这个问题,

与现有方法采用序列交叉视角运动补偿不同,LLSS引入双向特征移位模块,直接利用视图之间的相互信息,并通过联合交叉视角先验模型进行熵编码,从而有效地对视图进行编码。由于这种设计,LLSS并行处理左视图和右视图,最大限度地减少了延迟。另外与现有的神经和传统编解码器相比,它大大提高了性能。

虚拟现实等新视频模式的兴起增加了立体视频数据的显著增加。在VR中,为了实现身临其境的用户体验,对分辨率和延迟的要求非常高。所以,编解码器在保持低延迟的同时有效地编码立体视频至关重要。

立体视频编码的基本方法是将低延迟、单视图编解码器独立应用于每个视图。尽管这种传统的编解码器产生了有希望的结果,并已用于商业产品,如Meta

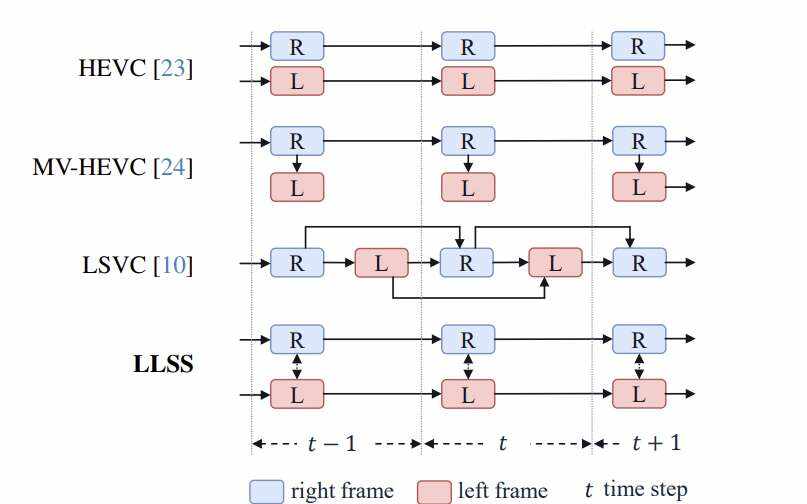

它们通常首先使用单视图编解码器对正确的视图框架进行编码。然后从编码后的右视图框预测左视图框。然而,这种顺序处理限制了同时处理多个视图的能力。

近年来,单视图神经视频编解码器取得了快速进展,特别是在低延迟设置中。例如,LSVC是一个神经编解码器,它取得了出色的效果,并且比MV-HEVC具有明显的优势,但它顺序处理左右视图帧,这限制了它在VR和AR等低延迟应用中的适用性。

在研究中,高通提出了一种低延迟立体视频串流LLSS编解码器,它设计用于并行立体视频编码。这个编解码器的开发基于两个关键的见解。

首先,受立体匹配方法最新进展的启发,与LSVC中复杂的运动补偿方案相比,左右视图之间的视差补偿模块可以大大简化。它可以用水平位移有效地表示。

其次,团队观察到视差补偿可以在两个视图中同时执行。仔细的编码器设计,在视图之间共享水平移动的特征,可以隐式地估计视差,同时促进两个视图的并行处理,从而实现低延迟推理。下图显示了方法的示意图比较:

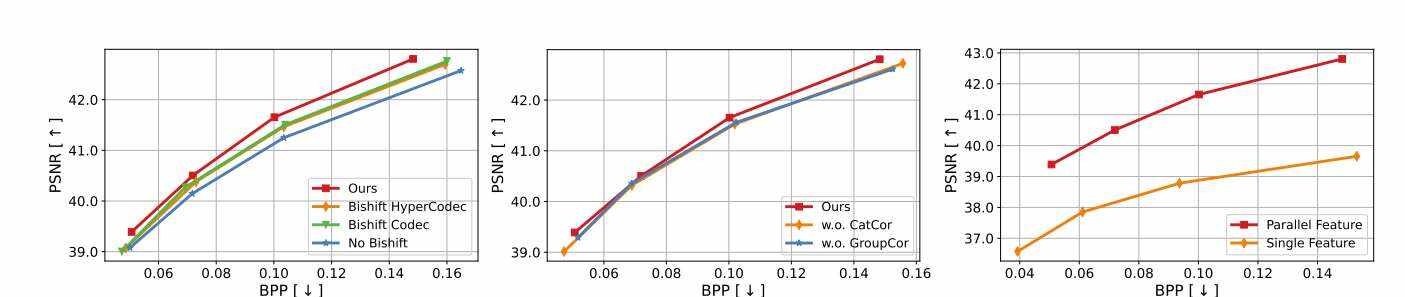

研究人员同时引入了一个新的组件:双向移位模块BiShiftMod它促进了网络中视图之间的连接和信息交换。这个模块集成在编解码器和超编解码器中,并可以实现跨视图互信息的数据依赖优化。通过遵循这种方法,团队用一个并行编码网络取代了顺序视差补偿。研究表明,与最先进的方法相比,高通提出的解决方案在三个常见的立体视频基准上大幅提高了R-D性能,在cityscape数据集上节省了50.6%的bd率,在KITTI2012数据集上节省了18.2%,在KITTI2015数据集节省了15.8%。

另外,团队提供了神经网络复杂度和推理时间的研究,并表明模型在FLOPS方面的复杂度仅为LSVC的35%。

Low-LatencyNeuralStereoStreaming

总的来说,团队提出了一种低延迟的神经立体视频压缩方法,它可以同时压缩左右视图。研究人员开发了一个双向移位压缩网络,有效地捕获了左右帧之间的冗余。实验表明,所述方法明显优于其他最先进的方法。另外,实验表明双向移位模块和并行自编码器有助于降低比特率和提高帧质量。