查看

只需拿出手机扫描一下真实环境,然后即可生成一个对应的虚拟环境并在VR头显中显示

(

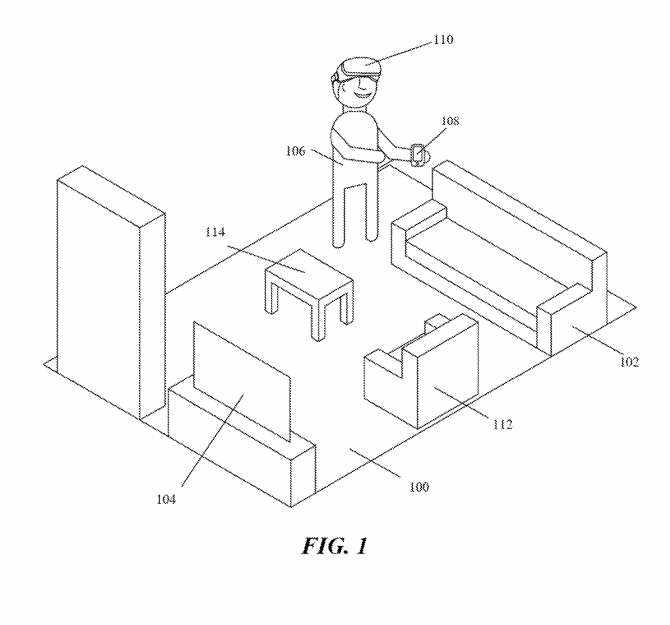

图1举例说明了一个真实世界的环境。举个例子,现实世界的环境可以是一个客厅。如图1所示,真实环境包括沙发102和112、咖啡桌114和电视104。在具体实施例中,真实世界环境可包括具有第一设备108和第二设备110的主机用户106。第一设备108可以是包括摄像头的智能手机,第二设备110可以是头显。

主机用户可以创建虚拟环境来托管客人并与之交互。为了生成虚拟空间,主机用户106将用第一设备108扫描客厅100。

主机用户106可以围绕诸如客厅100的物理环境走动以扫描整个房间。第一设备108包括捕获房间图像的摄像头和测量房间和房间内对象深度的深度传感器,以及包含可测量房间中对象的距离和深度范围的激光雷达传感器。

在具体的实施例中,第一设备108可以捕获以下一个或多个特征:环境的物理尺寸、环境中对象的物理尺寸、环境中对象的颜色和形状、房间和环境中对象的纹理、环境中对象的几何形状或其他。

第一设备生成真实世界环境的三维模型,然后第一设备将三维模型传输到头显。在具体实施例中,第一设备分析由第一设备收集的数据以识别房间中的对象或特征。例如,第一设备可以分析扫描的数据来识别家具、墙壁、图片/艺术品、窗户或门。

第一设备将从第一设备的传感器捕获的数据发送到头显,而头显使用接收到的数据生成三维模型。在特定实施例中,头显可以将三维模型传输到远程设备。

在一个实施例中,第一设备或第二设备的用户界面可以通知主机用户106房间100中需要扫描的缺失区域。在其他实施例中,第一设备或第二设备的用户界面可以通知主机用户106由于区域复杂性而可能需要扫描的区域。

在一个实施例中,人工现实系统将所扫描的房间可视化为主机用户可在第一设备108或第二设备110查看的图像。在具体实施例中,第一设备可以提供房间的多个可视化,每个可视化具有不同水平的质量或分辨率。

例如,在主机用户完成初始扫描之后,他可以重新扫描他或她希望以更高分辨率呈现的区域。在具体实施例中,人工现实系统识别到,通过重新扫描区域,主机用户希望以更高的分辨率呈现重新扫描的区域。在其他实施例中,主机用户可以选择以较低分辨率呈现的特定区域。例如,主机用户可能希望以较低的分辨率呈现私人物品,例如挂在墙壁的家庭肖像。

在另一个实施例中,人工系统可以使用深度学习方法来确定渲染对象或现实世界环境的一部分的特定分辨率。例如,深度学习算法可以识别特定区域或对象,例如孩子卧室或墙壁的全家福,并以较低的分辨率渲染相关区域或对象。

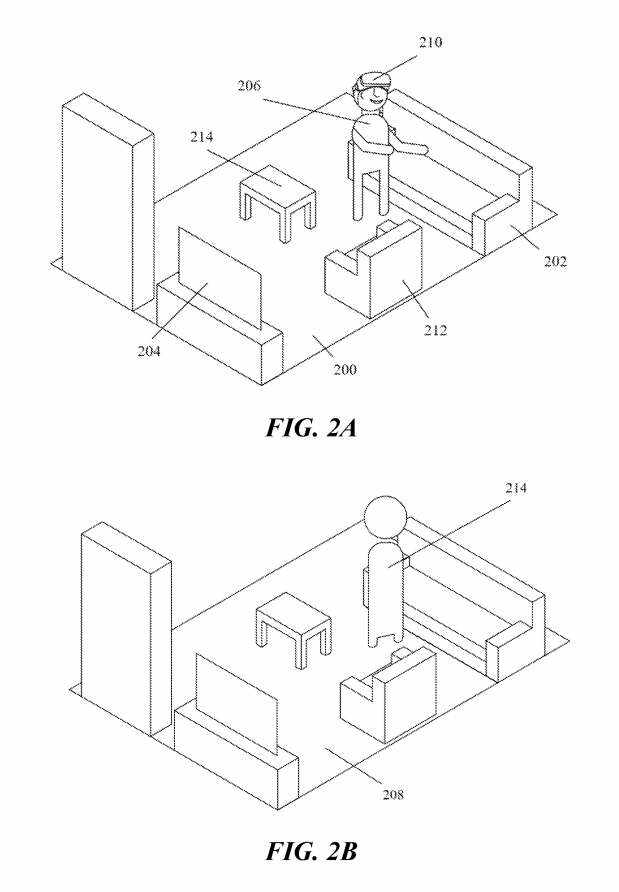

图2A和2B说明了与主机用户对应的示例第一Avatar。例如,图2A示出了一个真实世界场景,其中主机用户206站在客厅200中的位置。图2B示出了与现实世界环境相对应的虚拟环境示例。

虚拟环境208显示为虚拟客厅,它是由主机用户206扫描其真实世界的客厅200生成。图2B示出了与主机用户206对应的第一Avatar214。第一Avatar214站在虚拟客厅208中的位置与主机用户206站在真实世界客厅200中的位置大致相同。

在具体实施例中,在人工现实系统基于真实世界环境呈现虚拟环境后,主机用户可以保存虚拟环境以供将来使用。例如,主机用户可能希望在他的客厅主持会议,即使主机用户并不实际在场。

在另一个实施例中,虚拟环境可以保存在人工现实系统中,以协助同一房间的未来渲染。例如,如果主机用户在他的客厅举行第二次会议,并对他的客厅进行第二次扫描,则人工现实系统可以使用第一次渲染作为基线,并在第二次会议中实现扫描期间捕获的更改,以节省处理能力。

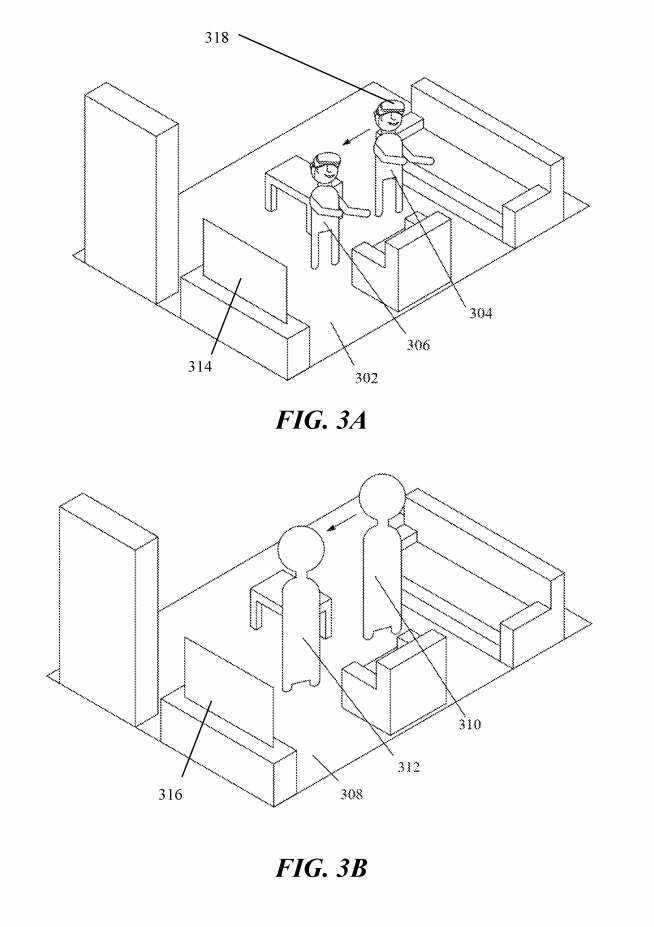

图3A和图3B示出与主机用户协调移动的示例第一Avatar。例如,在描绘真实世界环境302的图3A中,主机用户304向电视314移动到306所指示的位置。图3B所示的虚拟环境308显示了与所述主机用户一起移动的所述主机用户所对应的Avatar。

例如,当主机用户在真实世界环境中从位置304移动到位置306时,与主机用户对应的Avatar在虚拟环境中从位置310移动到位置312。

换句话说,当真实环境中的主机用户304向电视314移动时,所述主机用户对应的Avatar310同样向虚拟环境中的虚拟电视316移动。主机用户在306的位置对应于Avatar在312的位置。所述人工现实系统利用所述主机用户佩戴的头显318的摄像头,在第一设备生成的三维模型中追踪所述用户,并在第二设备对准所述头显视角生成的三维模型,从而追踪所述主机用户的运动。

另外,主机用户可以佩戴追踪设备,以追踪主机用户的手、手臂或手指中的一个或多个。作为示例,追踪设备可以是手控制器、手腕安装设备或手臂安装设备。

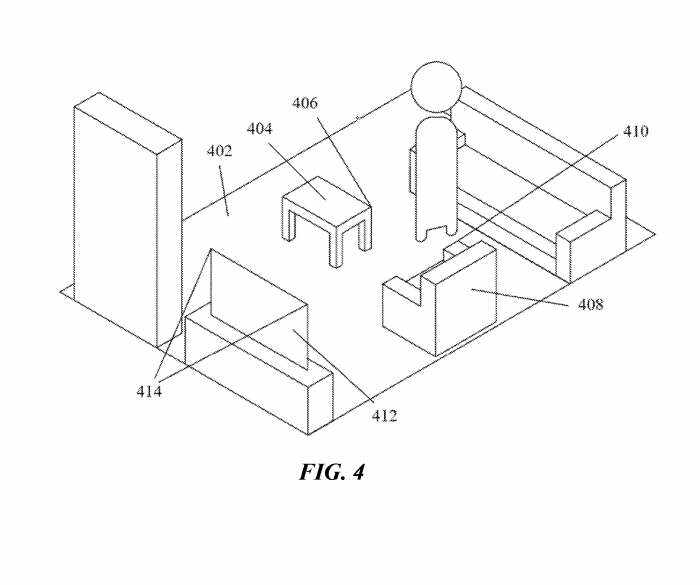

图4示出通过使用第一设备扫描真实世界环境而生成的示例虚拟环境。特征点由第一设备的传感器观察或拾取。特征点包括在真实世界环境的三维模型中。在具体实施例中,在第一设备确定特征点。在其他实施例中,将来自第一设备的传感器的数据传输到第二设备,并且在第二设备确定特征点。

在特定实施例中,主机用户的头部姿势被传输到与来宾用户相关联的远程设备。在特定实施例中,主机用户的头部姿势传输到多个远程设备,每个远程设备与特定的来宾用户相关联。在特定的实施例中,佩戴头显的主机用户可以在现实世界环境中自由移动,而不会撞到现实世界环境中的对象。在特定实施例中,当佩戴头显的主机用户扫描房间时,对准三维模型的过程发生。

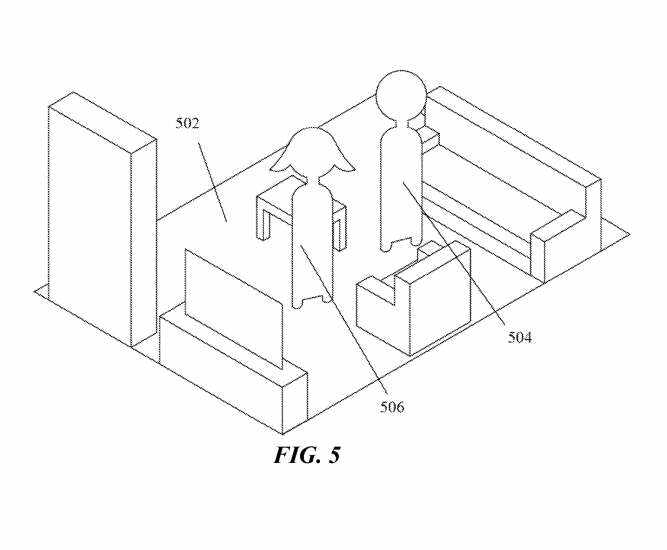

图5示出了站在虚拟空间中的与主机用户相对应的第一Avatar和与第二用户相对应的第二Avatar的示例。在特定实施例中,主机用户可能希望创建虚拟空间来邀请一个或多个来宾用户,以便主机用户和来宾用户可以相互交互。一个或多个来宾用户拥有自己的头显,而来宾用户可以位于世界任何地方。

在特定实施例中,一个或多个来宾用户各有一个远程设备。在具体实施例中,远程设备是头显、计算机、平板电脑或移动设备。来宾用户具有可通过控制器接收输入的头显和相关计算系统。另外,与来宾用户关联的Avatar出现在虚拟空间中。

例如,图5示出了示例性虚拟空间502、主机用户Avatar504和来宾用户Avatar506。Avatar504和506是用户的虚拟表示的示例表示。

在具体实施例中,与每个来宾用户相关联的每个远程设备接收来自主机用户和虚拟环境中的一个或多个其他来宾用户的头部姿势信息和位置信息。位置信息包括关于用户的Avatar或其他虚拟表示在虚拟环境中的位置的信息。

与每个来宾用户相关联的每个远程设备确定所述三维模型中所述来宾用户的位置和头姿,并将所述特定来宾用户的姿态和位置信息传输给与所述主机用户相关联的第二设备。与主机用户相关联的第二设备接收以下内容中的一个或多个:每个来宾用户的位置信息、每个来宾用户的头部姿势信息和每个来宾用户的身体姿势信息。使用接收到的信息,第二设备确定来宾用户在虚拟环境中的虚拟表示的位置、身体姿势和头姿位置。

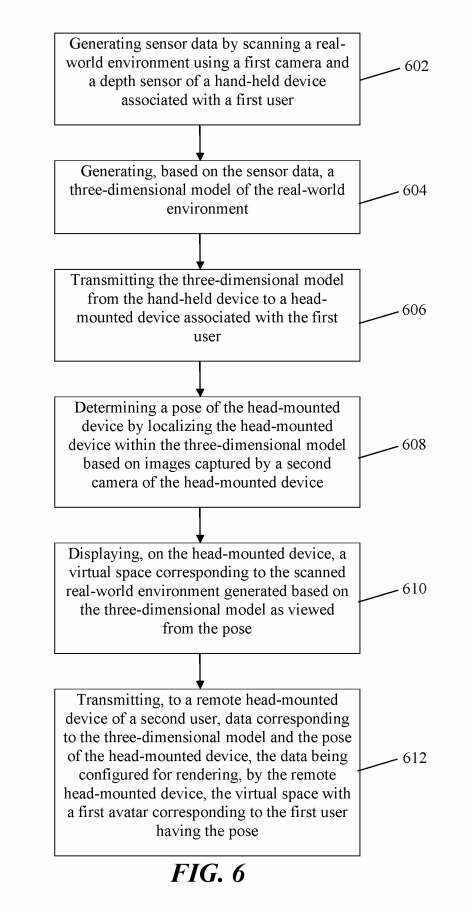

图6示出了使用第一设备扫描真实环境并通过第二设备显示的方法。

在步骤602,使用与第一用户关联的手持设备的第一摄像头和深度传感器描真实世界环境来生成传感器数据。

步骤604,基于传感器数据生成真实世界环境的三维模型。

步骤606,将三维模型从手持设备传输到与第一用户关联的头戴式设备。

步骤608,通过根据头戴设备的第二摄像头捕获的图像来将头戴设备定位在三维模型内来确定头戴设备的姿态。

步骤610,在头戴设备显示与真实世界环境相对应的虚拟空间,并将与所述头戴式设备的三维模型和姿态相对应的数据传输到第二用户的远程头戴设备。

步骤612,所述数据配置为由所述远程头戴式设备呈现具有与所述具有姿态的第一用户相对应的第一Avatar的虚拟空间。

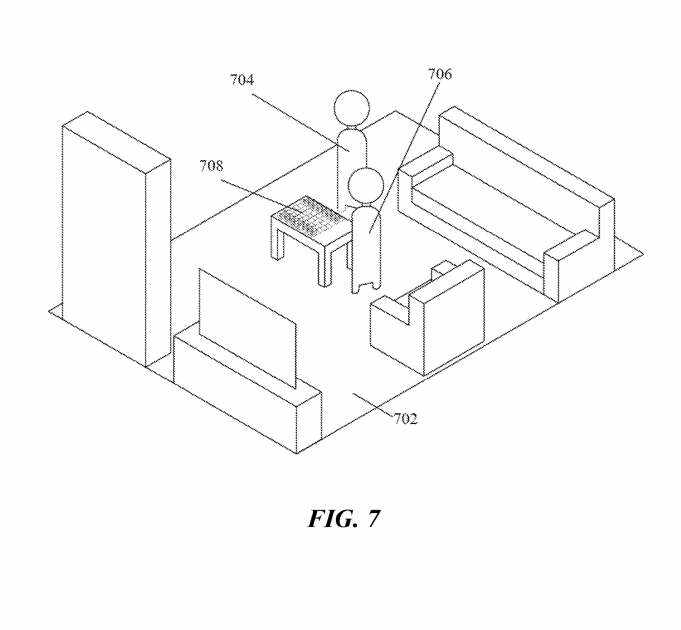

图7示出主机用户Avatar704和来宾用户Avatar706与虚拟空间702中的虚拟内容交互的示例。在具体实施例中,棋盘708由服务器同步。服务器将虚拟环境中的棋盘信息传输给与每个主机和来宾用户相关联的人工现实应用程序。虚拟内容从每个用户的角度呈现在虚拟环境中。

在特定实施例中,主机用户可以在真实世界环境中扫描对象,并且来宾用户可以将扫描的对象视为来宾用户设备的虚拟对象。在特定实施例中,主机用户可以与真实世界的对象进行交互,并将交互传输给来宾用户。例如,主机用户可以将第一棋子从第一位置移动到第二位置,并且来宾用户将看到相应的虚拟棋子从第一虚拟位置移动到第二虚拟位置。

在特定实施例中,主机用户的第二设备以预先确定的间隔执行额外扫描,以在主机用户与对象交互时更新真实世界环境的渲染。在特定实施例中,来宾用户可以与与来宾用户关联的虚拟棋子进行交互。在具体实施例中,主机用户可以与虚拟棋子交互。

举例来说,虚拟内容可以包括建筑设计、建筑材料或房间布局。主机用户和来宾用户可以通过移动虚拟内容、删除虚拟内容、添加新的虚拟内容或修改现有内容与虚拟内容进行交互。

在特定实施例中,主机用户和/或访客用户可以将第一设备放置在真实世界环境中的某个位置,以允许第一设备在呈现虚拟环境后继续扫描所述环境。第一设备可用于捕获用户的身体姿势信息。

将捕获的身体姿势信息发送到服务器,服务器将信息传输到连接到服务器的人工现实应用程序。每个用户的Avatar对应于每个用户的实际身体动作。

MetaPatent|Methodofgeneratingavirtualenvironmentbyscanningareal-worldenvironmentwithafirstdeviceanddisplayingthevirtualenvironmentonaseconddevice

名为“Methodofgeneratingavirtualenvironmentbyscanningareal-worldenvironmentwithafirstdeviceanddisplayingthevirtualenvironmentonaseconddevice”的Meta专利申请最初在2022年8月提交,并在日前由美国专利商标局公布。