查看

基于眼睛注视位置的视频流式传输

(

实际上,诸如

在一个实施例中,计算系统可以利用注视估计系统来估计用户的注视位置,从而允许处理器降低用户未积极查看的视频流的质量。

视频流可以基于是否要在用户的注视点区域内显示而进行不同的处理。注视位置可由使用所述图像传感器的计算系统估计、检测或以其他方式确定。

即,图像传感器可获取一幅或多幅图像,并基于所述一幅或多幅图像估计注视位置。然后可以使用估计注视位置来处理要显示给用户的视频流,例如降低在估计注视位置之外显示的视频流的图像质量,增加在估计注视位置内显示的视频流的图像质量等。

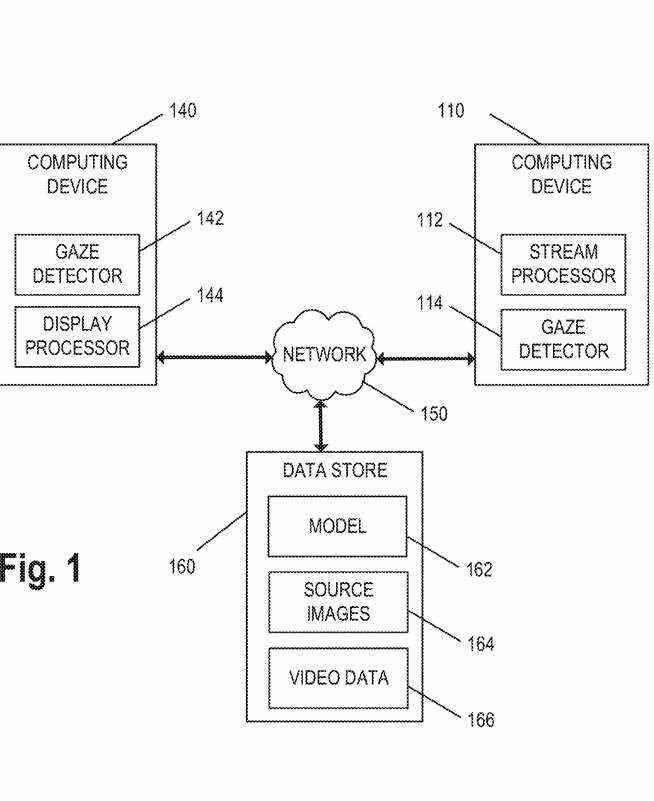

图1描述的视频处理系统100,配置为基于用户的估计注视位置处理视频流。视频处理系统100包括计算设备110和显示设备120。

计算设备110通常配置为接收多个视频流并向显示设备120提供视频流的表示,以便显示给用户102。计算设备110的示例包括网络服务器、云服务器或其他合适的计算设备。

计算设备110可以包括处理视频流以传输到显示设备120的流处理器112。在各种实施例中,流处理器112配置为在传输到显示设备120之前降低至少一个视频流的传输比特率。计算设备110同时可以包括配置为识别用户102的估计注视位置的注视检测器114。注视探测器114配置为利用神经网络模型,例如神经网络模型162。

显示设备120包括具有视场并能够获取用户102的一个或多个图像的图像传感器132,显示设备120和/或计算设备110利用图像传感器132捕获的图像来识别用户102的估计注视位置。

图像传感器132可以获得用户102的一个或多个图像,其中用户102位于图像传感器132的视场内。然后,可将由图像传感器132获取的一个或多个图像提供给在神经处理单元执行的神经网络模型。

神经网络模型可以确定并向流处理器112提供用户102的注视信息,例如估计的注视位置。由于神经处理单元是专门设计和/或编程来处理神经网络任务,所以其对资源的消耗比使用中央处理单元的消耗要少。

所述神经网络模型确定并提供的注视信息可包括所述用户102的估计注视位置。用户的估计注视位置可以对应于显示器130和/或周围的位置,例如X、Y、Z坐标。

显示处理器144配置为在一个或多个视频流执行一种或多种图像增强算法,例如,增加视频流的空间分辨率或帧速率的超分辨率算法、稀疏重建算法、焦点解码算法或其他合适的图像增强算法。

换句话说,所述显示处理器144配置为处理具有相对较低图像质量的第一视频流以生成具有相对较高图像质量的第二视频流。所述显示处理器144可利用所述估计注视位置来选择用于所述图像增强算法的所述接收视频流的子集,例如仅在所述估计注视位置内的视频流。

以这种方式,计算设备140在用户注视时提供高质量视频流,但在用户无法轻易辨别额外细节时提供低质量视频流,这节省了用于其他活动的处理器周期。

神经网络模型162配置为基于用户的一个或多个图像估计用户的注视位置。可以训练神经网络模型162使用源图像164来估计注视位置,并且训练神经网络模型162以识别相关区域。视频数据166可以包括录制的视频、视频流或可用于生成视频流的数据。

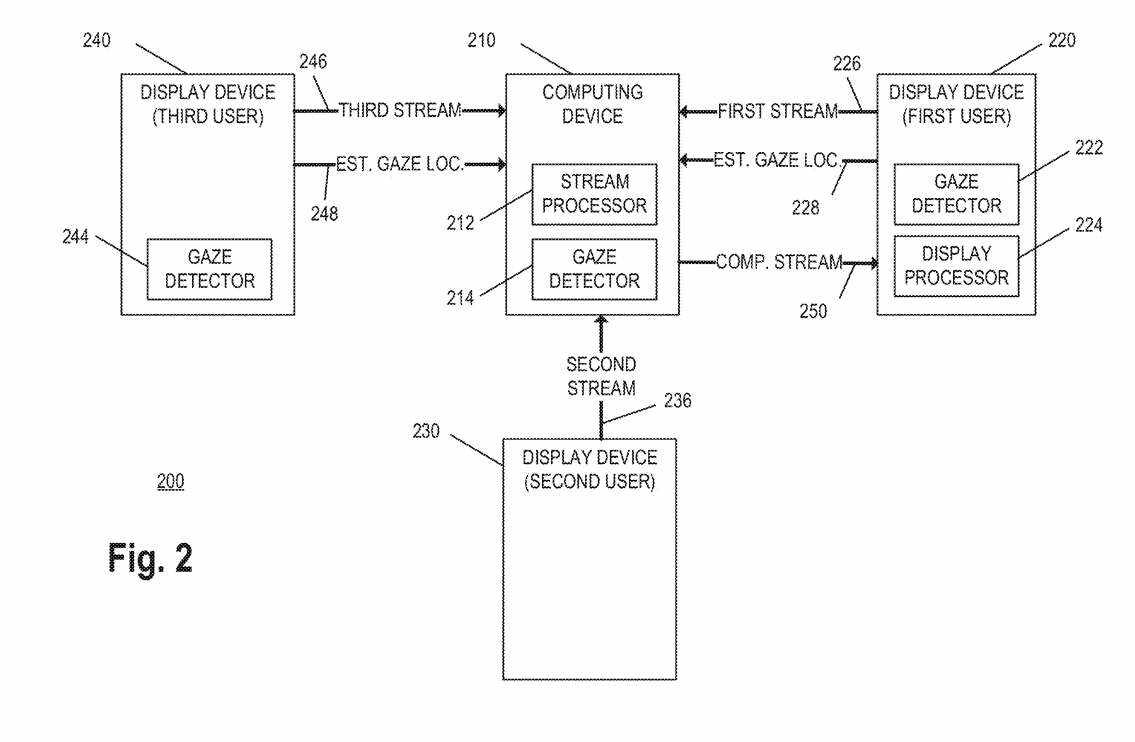

图2描述了视频处理系统200的示例。视频处理系统200包括计算设备210、用于第一用户的第一显示设备220、用于第二用户的第二显示设备230和用于第三用户的第三显示设备240。计算设备210通常对应于图1中的计算设备110,并且包括流处理器212。计算设备210同时可以包括注视探测器214。

第一显示设备220一般对应于图1中的显示设备120,包括注视探测器222和显示处理器224。第一显示设备220使用诸如图像传感器132的图像传感器捕获第一视频流226。另外,第一显示设备220识别第一用户的估计注视位置228。所述第一显示设备220将所述第一视频流226和所述估计注视位置228传输到所述计算设备210。

第二显示设备230配置为显示从计算设备210接收的视频流,并使用合适的图像传感器捕获第二视频流236。例如,所述图像传感器可以类似于所述图像传感器132。

第三显示设备240一般对应于图1中的显示设备120,并包括注视探测器244。第三显示设备240使用诸如图像传感器132的图像传感器捕获第三视频流246。另外,第三显示设备240识别第三用户的估计注视位置248。第三显示设备240将第三视频流246和估计注视位置248传输到计算设备210。

流处理器212配置为在传输到第一显示设备220之前降低第二视频流236和第三视频流246中的至少一个的传输比特率。通过降低传输比特率,计算设备210减少将合成视频流250传输到第一显示设备220所需的带宽量。另外,在显示复合视频流时,较低的传输比特率同时提供了第一显示设备220的更低功耗或更快的显示帧率。

在各种实施例中,流处理器212通过减少像素计数、减少帧速率、改变调色板或色彩空间、改变视频编码格式、降低音频质量或其任何组合来降低视频流的传输比特率。作为一个示例,流处理器212通过从1920×1080像素重采样到1280×720像素或通过裁剪到更小的尺寸来减少视频流的像素计数或分辨率。

作为另一个示例,流处理器212将帧速率从每秒60帧降低到每秒30帧或每秒24帧。在另一个示例中,流处理器212将视频编码格式更改为更有效的编码格式,例如从H.262格式更改为H.264或H.265格式。

在一个实施例中,流处理器212通过解码视频流以获得解码的数据来执行上述处理,然后以不同的视频编码格式对解码的数据进行编码或改变视频编码格式的参数以降低传输比特率。在其他实施例中,流处理器212将视频流转码为不同的视频编码格式(。

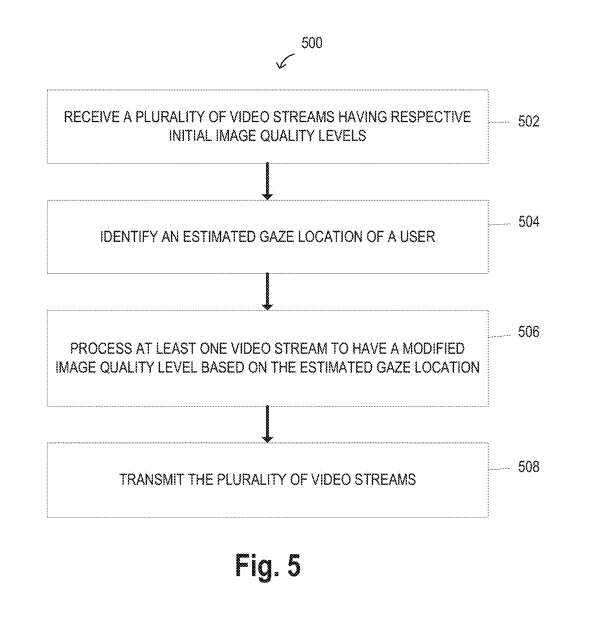

图5描述了处理视频流的方法500。

从步骤502开始,接收多个视频流以传输到显示设备。所述多个视频流具有各自的初始图像质量水平。所述多个视频流对应于所述视频流226、236和246,所述显示设备对应于实施例中的第一显示设备220。在另一实施例中,多个视频流对应于视频流360、370和380,显示设备对应于显示设备130。

在步骤504,识别显示设备的用户的估计注视位置。从显示设备,例如从注视探测器142或222接收估计的注视位置。在其他实施例中,从显示设备接收一个或多个图像,从图像中提取多个特征,将多个特征提供给神经网络,并且将估计的注视位置确定为使用该神经网络引导用户注视的位置。

在步骤506,将多个视频流中的至少一个视频流处理为具有基于估计注视位置的修改的图像质量水平。修改后的图像质量级别小于相应的初始图像质量级别。修改后的图像质量级别具有减少的像素数、减少的帧速率和增加的压缩中的至少一种。

在步骤506,基于显示设备显示的至少一个视频流与估计注视位置之间的距离,从多个质量水平中选择修改的图像质量水平。

在步骤508,将多个视频流传输到所述显示设备。在一个实施例中,生成并传输到显示设备的复合视频流包括具有修改的图像质量水平的至少一个处理过的视频流和多个视频流的剩余视频流。

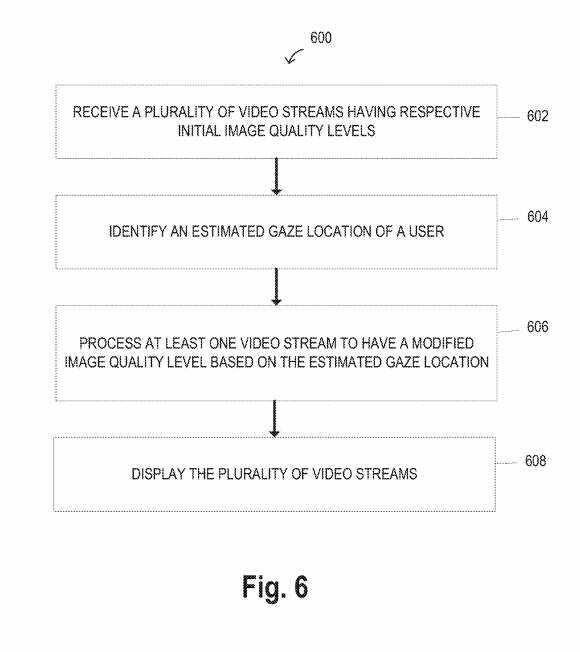

图6描述了用于处理视频流的方法600。

从步骤602开始,接收多个视频流以供显示设备显示。所述多个视频流具有各自的初始图像质量水平。初始图像质量水平相对较低,例如降低视频流的传输比特率。

在步骤604,识别显示设备的用户的估计注视位置。在一个实施例中,估计注视位置对应于估计注视位置。在一个实施例中,估计的注视位置由显示设备的注视检测器确定,例如由注视检测器142或222确定,并提供给显示处理器144。

在步骤606,将多个视频流中的至少一个视频流处理为具有基于估计注视位置的修改的图像质量水平。修改后的图像质量级别高于相应的初始图像质量级别。修改后的图像质量级别具有增加的像素数、增加的帧速率和减少的压缩中的至少一种。

在一个实施例中,显示处理器144在至少一个视频流执行一种或多种图像增强算法,例如增加视频流的空间分辨率或帧速率的超分辨率算法、稀疏重建算法、焦点解码算法或其他合适的图像增强算法。

在一个实施例中,显示处理器144选择在估计注视位置内的视频流,并仅对选定的视频流执行图像增强算法。

在步骤608中,多个视频流由显示设备显示。

微软专利申请最初在2023年8月提交,并在日前由美国专利商标局公布。

需要注意的是,一般来说,美国专利申请接收审查后,自申请日或优先权日起18个月自动公布或根据申请人要求在申请日起18个月内进行公开。注意,专利申请公开不代表专利获批。在专利申请后,美国专利商标局需要进行实际审查,时间可能在1年至3年不等。