查看

对象或动态场景的新视图合成

(

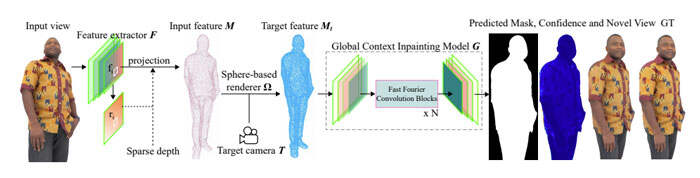

为了应对上述挑战,Meta和芬兰奥卢大学的研究人员提出了全新的HumanViewSynthesisNetwork(HVS-Net),通过利用紧凑而有效的公式,以及商品RGB-D传感器来生成穿衣人体的高保真渲染图像。

团队提出的挑战性要求是:

- 与每个受试者训练的模型相比,测试时对新受试者的泛化

- 处理人类在不可见姿态下的动态行为的能力,而不是使用训练时看到的相同姿态对人类进行动画化

- 处理遮挡(来自对象或自遮挡)的能力

- 捕捉面部表情

- 在给定单流稀疏RGB-D输入的实时设置中生成高保真图像(类似于低成本的现成深度摄像头)。

基于球体的视图合成

管道第一部分的目标是从不同的角度尽可能忠实地呈现人类的稀疏RGB-D视图。在上述伪影中,它主要可以处理由于深度缩短而导致的球体固有稀疏性:从两个相邻像素中的单个视点来看,无论它们有多大差异,你只能在它们各自的深度处获得信号。这意味着,对于每两个深度差异较大且从侧面看的像素,会出现较大的间隙。对于渲染人体对象,“间隙”大小有限,可以通过使用基于球体的渲染器进行视图合成,从而在一定程度上解决这个问题。

基于球体的渲染器:给定原始视点的每个像素的深度以及camera参数,点可以自然地投影到新的视图中。这使得基于深度的扭曲或可微分点或球化器的使用成为视图合成模型开发的第一步的自然选择。所述渲染器越能将初始信息转换为新视图,效果越好。另外,投影步骤是自动校正的(传感器噪点除外),并且不受训练误差的影响。

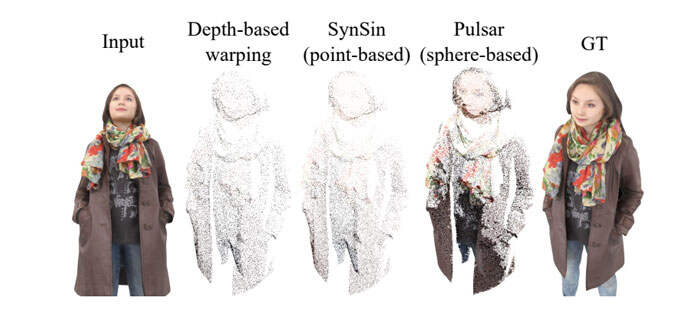

图2

图2使用三种不同的方法比较了单个稀疏RGBD输入的扭曲图像的密度:基于深度的扭曲、基于点的渲染和基于球体的渲染。基于深度的扭曲将RGD-D输入表示为一组像素大小的3D点,因此,新视图中正确投影的像素对输入视图的密度非常敏感。

广泛使用的基于可微分点的渲染器引入了全局每点半径参数,所述参数允许生成更密集的图像。但是,由于它对所有点使用相同的半径,因此会有一个折衷:如果半径选择得太大,输入图像密集区域的细节将丢失;如果半径选择得太小,则生成的图像在稀疏区域中变得更稀疏。

最近引入的基于球体的Pulsar渲染器不仅提供了使用每个球体半径参数的选项,并且提供了半径的梯度,使得能够动态设置它们。如图2所示,与其他方法相比,这允许产生更密集的图像。

处理遮挡

基于球体的视图合成网络S以高质量预测可信的新视图。然而,如果人持有诸如钱包之类的物体,或者如果他们的手阻碍了他们躯干的大部分,则扭曲变换将导致该区域中的缺失点。这导致当使用不接近输入视图的目标camera执行新视图合成时,被遮挡区域出现低保真度纹理估计。

因此,为了进一步提高新视图的质量,研究人员引入了两个附加模块:

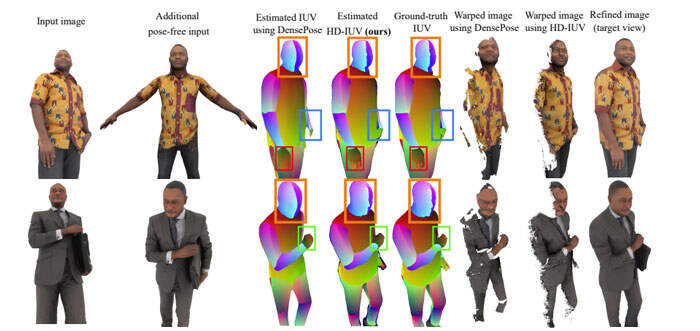

- HD-IUV预测器D,用于预测RGB图像(人体渲染)和人体模板的3D表面之间的密集对应关系,

- 细化模块R,用于将附加的无遮挡输入扭曲到目标camera,并增强初始估计的新视图以解决自遮挡问题。

首先估计将人的RGB图像映射到身体模板的3D表面的表示。团队可以使用DensePose来完成这项任务,但估计的IUV(其中I反映身体部分)预测仅涵盖裸体,而不是穿衣人体,并且不准确,因为它们是基于稀疏和噪点的人类注释进行训练。相反,他们构建了自己的IUV预测器,并在合成数据对其进行训练,从而获得准确的groundtruth相对应。

利用合成RGB图像对和groundtruth密集表面对应,他们训练了一个类似UNet的网络,为穿衣人体的每个像素提供密集表面(即IUV)估计。对于前景图像中的每个像素p,预测表示对应关系的通道(RGB)颜色p′。这种表示中的颜色是唯一的,这使得随后的扭曲变得容易。因此,他们将整个问题视为多任务分类问题,其中每个任务(对I、U和V通道的预测)用以下一组损失进行训练。

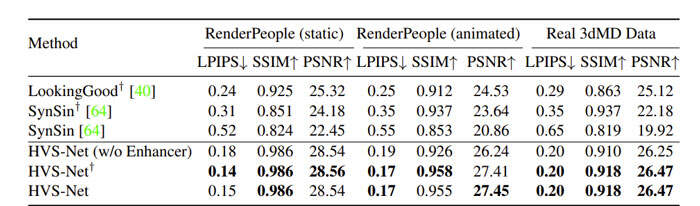

结果

表1

Free-ViewpointRGB-DHumanPerformanceCaptureandRendering

总而言之,HVSNet是一种在给定单个稀疏RGB-D源的情况下对运动中的人类执行新视图合成的方法。HVS网络使用基于球体的视图合成模型,产生目标视图的密集特征;然后,所述数据与自动编码器一起用于完成目标视点的缺失细节。为了应对严重遮挡区域,他们提出了一种增强器模块,使用人类的额外非遮挡视图来提供额外信息,并基于新的IUV映射产生高质量结果。所述方法在各种新姿态下,以不可见人类的新视图生成高保真渲染,并可以忠实地捕捉和渲染训练中不存在的面部表情。这一点尤其显著,因为他们仅基于合成数据训练HVSNet,但它在合成和真实示例中都实现了高质量的结果。