查看

在二维图像域而不是三维空间中实时检测场景变化

(

在名为“Scenechangedetectionwithnovelviewsynthesis”的专利申请中,

系统首先使用视觉定位将第一会话的坐标系统对齐到第二会话。然后,系统应用NeRF模型生成新图像。NeRF模型使得系统能够在没有特定场景训练的情况下生成新图像。系统从新图像的特征中减去第一会话的第一图像的特征,从而识别场景变化。

在一个示例中,变化的梯度在热图中以不同的颜色显示。然后,系统将热图显示为第一图像或新图像的叠加。

在一个示例实施例中,用于检测场景中的变化的方法包括:访问与AR设备的第一用户会话相关联的第一坐标系中的第一组图像和相应的姿势数据;访问与AR设备的第二用户会话相关联的第二坐标系统中的第二组图像和对应的姿势数据。

然后,基于将第一组图像的姿势数据映射到第二组图像的姿态数据,将第一坐标系与第二坐标系对准。在对准第一坐标系和第二坐标系之后,基于在空间上最接近第二图像的姿态数据确定的第一图像集的姿态数据,从而识别与来自第二图像集的第二图像相对应的第一图像集合。

接下来,使用经过训练的神经网络从第一组图像生成合成图像,从合成图像的特征确定第二图像的特征之间的差异,并基于差异识别变化。

因此,通过检测二维图像的特征向量的变化而不是从三维坐标系中检测RGB值,这有助于解决节省功耗的技术问题。

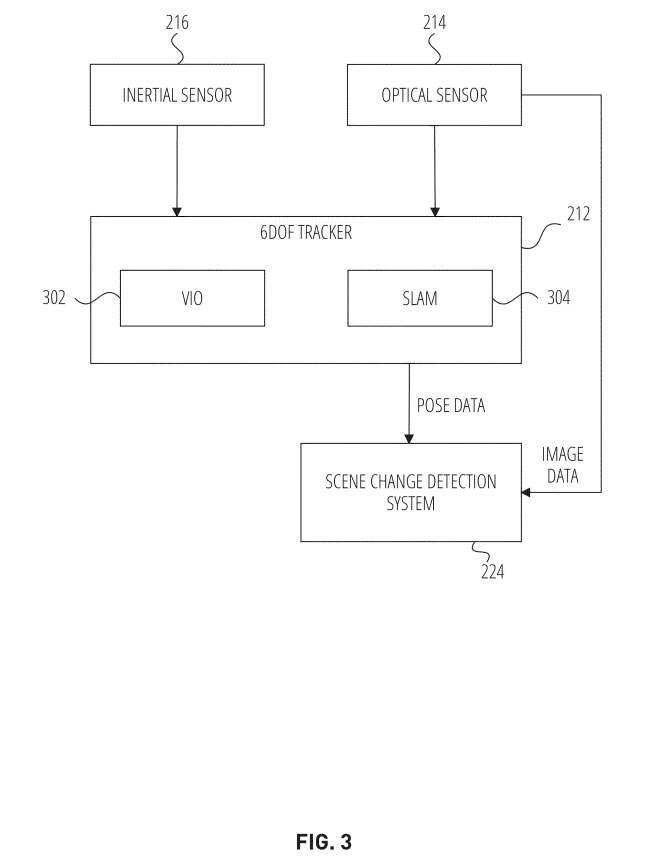

图3示出一个六自由度追踪器212。六自由度追踪器212访问来自惯性传感器216的惯性传感器数据和来自光学传感器214的光学传感器数据。

六自由度追踪器212确定AR设备110相对于参考帧的姿态。在一个示例实施例中,六自由度追踪器212包括VIO302和SLAM304。六自由度追踪器212根据光学传感器214捕获的图像和惯性传感器216捕获的惯性传感器数据中的特征点3D地图估计AR设备110的姿态。

六自由度追踪器212向场景变化检测系统224提供姿态数据。光学传感器214向场景变化检测系统224提供图像数据。场景变化检测系统224使用姿态数据将当前会话的坐标系统与前一个会话对齐。

例如,场景变化检测系统224使用姿态数据在同一坐标系中比较当前会话和前一个会话的轨迹。场景变化检测系统224使用来自对齐坐标系的姿态数据将当前会话的相应图像与来自前一会话的图像进行映射和识别。

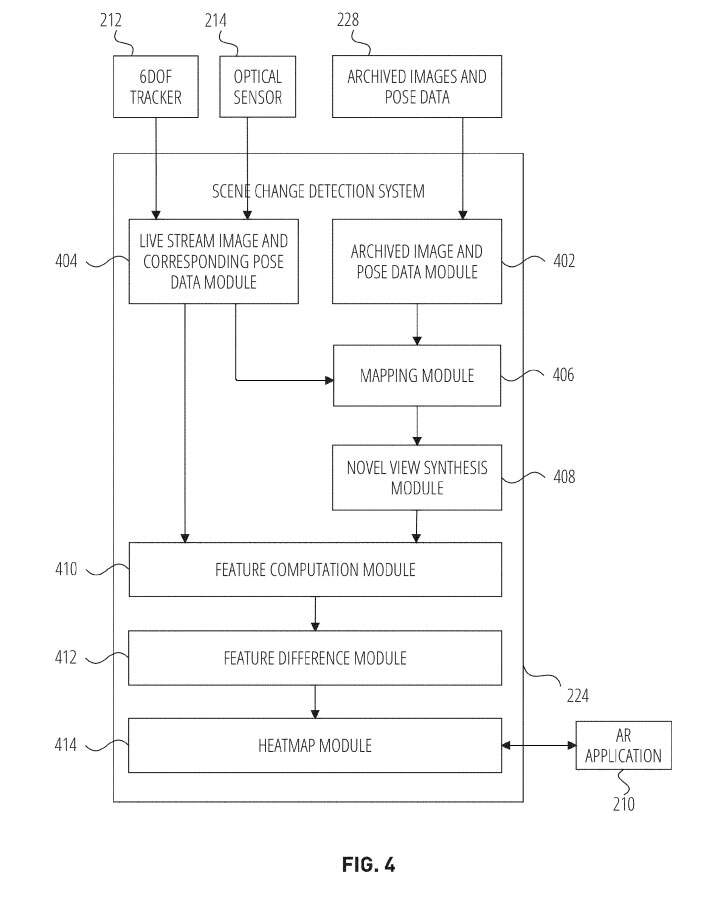

图4示出了一个场景变化检测系统224。场景变化检测系统224包括存档图像和姿势数据模块402、实时流图像和相应位姿数据模块404、映射模块406、新视图合成模块408、特征计算模块410、特征差模块412和热图模块414。

实时流图像和相应位姿数据模块404访问来自光学传感器214的实时流图像和来自六自由度追踪器212的相应位姿数据。在一个示例中,实时流图像和相应的姿态数据模块404访问来自光学传感器214的来自当前会话的多个图像帧和来自六自由度追踪器212的相应姿态数据。

所述存档图像和姿态数据模块402从所述存储设备206检索存档图像和姿态数据228。在一个示例中,存档图像和姿势数据228对应于佩戴相同或不同AR设备110的相同或其他用户的先前会话。

在另一个示例中,所述存档图像和姿态数据模块402识别来自当前会话的姿态数据识别特定位置,并检索先前由AR设备110在前一个会话期间在同一会议室捕获的图像。

映射模块406将当前会话中的图像映射到前一个会话中的图像。例如,映射模块406对图像进行映射,使得当前图像中的特征/像素在将来自当前会话的二维坐标与先前会话对齐后对应于存档图像中的特征。

在一个示例中,映射模块406根据当前会话中AR设备110的姿态数据确定当前会话中AR设备110的轨迹,并根据前一会话中110的姿态数据将其与前一会话中AR设备110的轨迹进行比较。

新视图合成模块408基于来自当前会话或来自先前会话的姿态数据生成合成图像。例如,新视图合成模块408将基于广义NeRF的神经网络模型应用于当前会话的图像,从而生成合成图像。

换句话说,新视图合成模块408从AR设备110的新视图/角度生成新图像。

特征计算模块410从合成图像中计算特征或访问基于广义NeRF的神经网络模型固有的特征.特征差异模块412确定参考图像的特征与合成图像的特征之间的差异。在一个示例中,特征差模块412用合成图像的特征减去前一会话的图像的特征。

在另一示例中,特征差模块412从合成图像的特征中减去当前会话图像的特征。在另一个示例中,特征差模块412计算两个向量的差。测量差异的其他方法包括测量两个特征向量的角度差异。

热图模块414基于从特征差模块412计算的特征相减来确定梯度值。热图模块414基于合成图像二维域中每个像素的梯度值生成热图。热图包括分配给不同梯度值的不同颜色,以识别场景/图像中变化的强度。热图模块414将热图提供给AR应用210。AR应用程序210在显示器204中显示热图,以便热图作为覆盖显示。

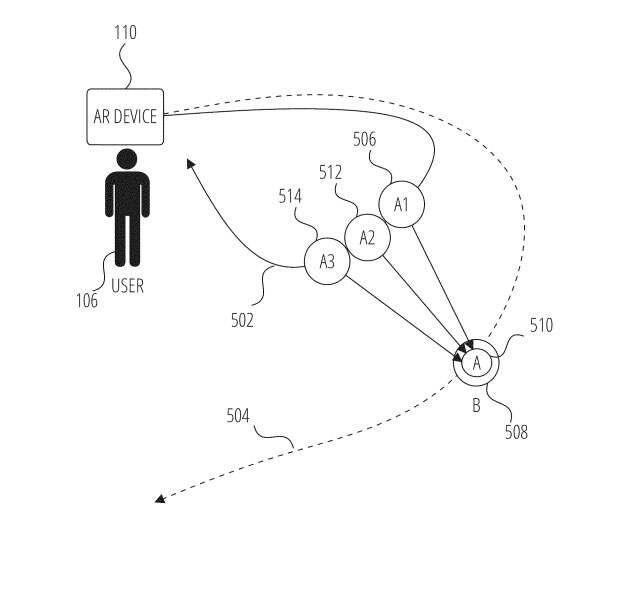

图5示出一个AR设备110的示例轨迹。用户106佩戴AR设备110,并在当前会话中沿着轨迹502行走。场景变化检测系统224识别AR设备110在先前会话中的轨迹504。

场景变化检测系统224首先使用使用六自由度追踪器212的相同参照系或坐标系将轨迹502与轨迹504对齐。场景变化检测系统224沿着轨迹502从用户106的当前位置识别一组图像。场景变化检测系统224生成与图像508的姿态数据相对应的合成图像。

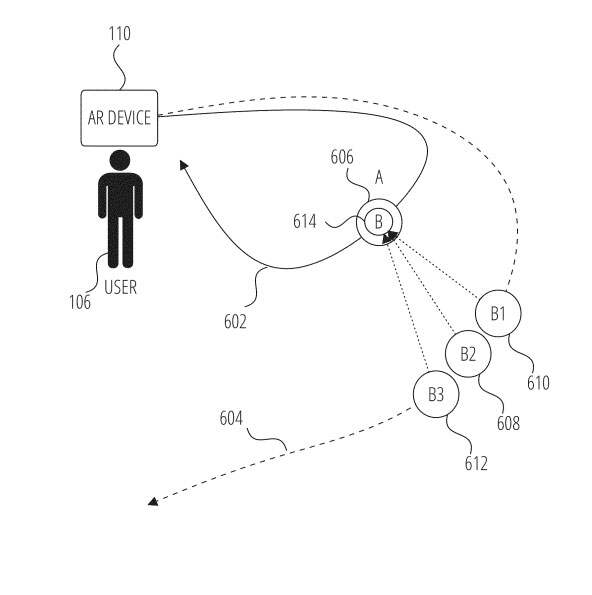

图6示出一个AR设备110的示例轨迹。用户106佩戴AR设备110,并在当前会话中沿着轨迹602行走。场景变化检测系统224识别AR设备110在先前会话中的轨迹604。

场景变化检测系统224首先使用使用六自由度追踪器212的相同参照系或坐标系将轨迹602与轨迹604对齐。场景变化检测系统224沿着轨迹604识别来自AR设备110的先前位置的一组图像。场景变化检测系统224生成与图像606的姿态数据相对应的合成图像。

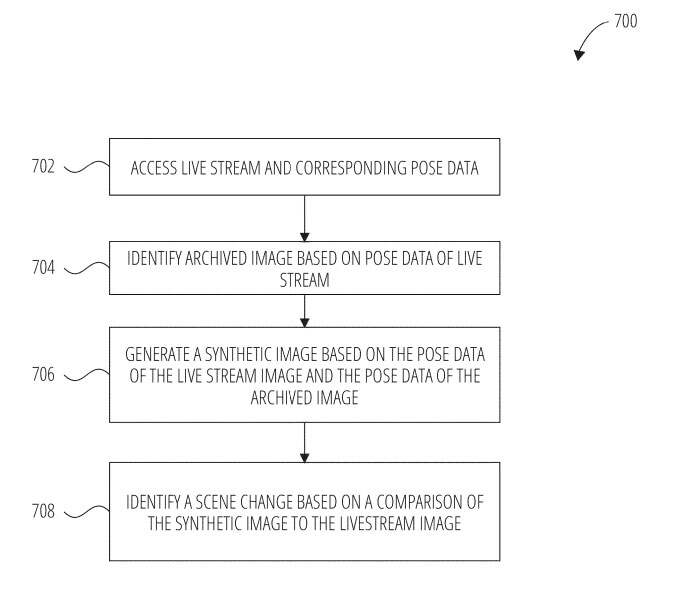

图7是测场景变化的方法流程图。方法700中的操作可以通过场景变化检测系统224来执行。

在702中,实时流图像和相应的位姿数据模块404访问实时流和相应的位姿数据。

在704中,存档图像和位姿数据模块402根据实时流的位姿数据识别存档图像。

在706中,新视图合成模块408基于实时流图像的位姿数据和存档图像的位姿数据生成合成图像。

在708中,特征差异模块412基于合成图像与直播图像的比较识别场景变化。

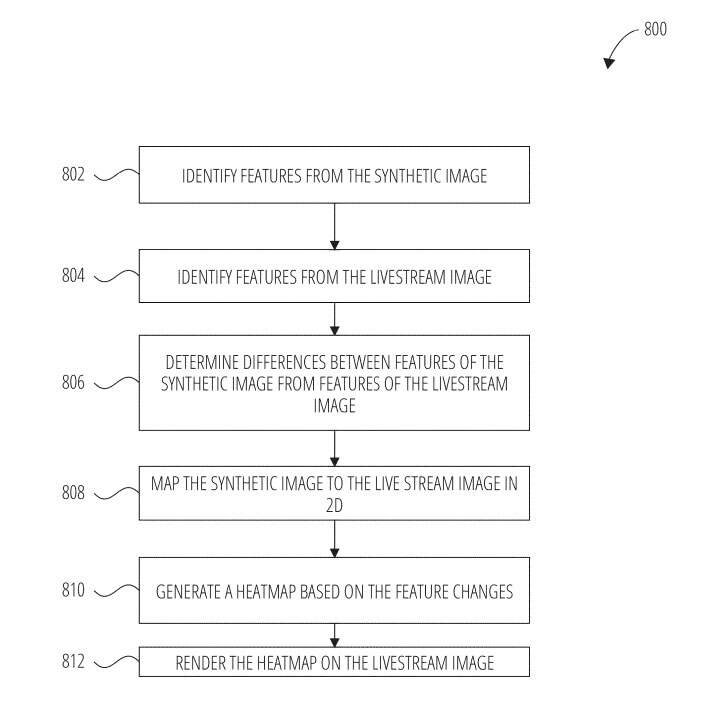

图8示出呈现热图的方法流程图。方法800中的操作可以通过场景变化检测系统224来执行。

在802中,特征计算模块410识别来自合成图像的特征。

在804中,特征计算模块410识别来自直播图像的特征。

在806中,特征差模块412确定合成图像的特征与流图像的特征在2D向量上的差异。

在808中,特征差模块412将合成图像映射到2D的实时流图像。

在810中,热图模块414根据所述特征变化生成热图。

在812中,AR应用程序210在实时流图像上呈现热图。

SnapPatent|Scenechangedetectionwithnovelviewsynthesis

名为“Scenechangedetectionwithnovelviewsynthesis”的Snap专利申请最初在2022年2月提交,并在日前由美国专利商标局公布。